Dimitri Bertsekas - Dimitri Bertsekas

Dimitri P. Bertsekas | |

|---|---|

| |

| Née | 1942 |

| Nationalité | grec |

| Citoyenneté | Américain, Grèce |

| mère nourricière | Université technique nationale d'Athènes (1968) |

| Connu pour |

Programmation non linéaire Optimisation convexe Programmation dynamique Programmation dynamique approximative Systèmes stochastiques et contrôle optimal Optimisation du réseau de communication de données |

| Récompenses | 1997 Prix INFORMS Computing Society (ICS) 1999 Prix national grec pour la recherche opérationnelle 2001 ACC John R. Ragazzini Education Award 2001 Membre de la National Academy of Engineering des États-Unis 2009 INFORMS Expository Writing Award 2014 AACC Richard E. Bellman Control Heritage Award 2014 INFORMS Khachiyan Prix 2015 SIAM/MOS Dantzig Prize 2018 INFORME Prix John von Neumann Théorie 2022 IEEE Control Systems Award |

| Carrière scientifique | |

| Des champs | Optimisation , Mathématiques , Théorie du contrôle et Réseaux de communication de données |

| Établissements |

L'Université George Washington Université Stanford Université de l'Illinois à Urbana-Champaign Massachusetts Institute of Technology |

| Thèse | Contrôle des systèmes incertains avec une description ensembliste de l'incertitude (1971) |

| Conseiller de doctorat | Ian Burton Rhodes |

| Autres conseillers pédagogiques | Michel Athans |

| Doctorants |

Steven E. Shreve Paul Tseng Asuman Özdağlar |

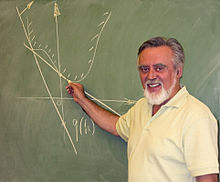

Dimitri Panteli Bertsekas (né en 1942 à Athènes , grec : Δημήτρης Παντελής Μπερτσεκάς ) est un mathématicien appliqué , ingénieur électricien et informaticien , professeur McAfee au département de génie électrique et informatique de la faculté d'ingénierie du Massachusetts Institute of Technology ( MIT), Cambridge, Massachusetts , et également professeur Fulton de prise de décision informatique à l' Arizona State University, Tempe .

Biographie

Bertsekas est né en Grèce et y a vécu son enfance. Il a étudié pendant cinq ans à l' Université technique nationale d'Athènes , en Grèce et a étudié pendant environ un an et demi à l'Université George Washington , à Washington, DC , où il a obtenu sa maîtrise en génie électrique en 1969, et pendant environ deux ans à MIT , où il a obtenu son doctorat en science des systèmes en 1971. Avant de rejoindre la faculté du MIT en 1979, il a enseigné pendant trois ans au département d'ingénierie et de systèmes économiques de l'université de Stanford et pendant cinq ans au département de génie électrique et informatique. de l' Université de l'Illinois à Urbana-Champaign . En 2019, il a été nommé professeur à temps plein à la School of Computing, Informatics, and Decision Systems Engineering de l' Arizona State University , Tempe, tout en conservant un poste de chercheur au MIT.

Il est connu pour ses travaux de recherche, et pour ses dix-huit manuels et monographies en optimisation et contrôle théoriques et algorithmiques , et en probabilités appliquées . Ses travaux vont du travail théorique/fondamental à l'analyse et à la conception algorithmiques pour les problèmes d'optimisation, et à des applications telles que les réseaux de communication et de transport de données et la production d'énergie électrique . Il figure parmi les 100 auteurs les plus cités en informatique dans la base de données académique et la bibliothèque numérique du moteur de recherche CiteSeer . En 1995, il co-fonde une maison d'édition, Athena Scientific, qui publie entre autres la plupart de ses livres.

À la fin des années 90, Bertsekas a développé un vif intérêt pour la photographie numérique . Ses photographies ont été exposées à plusieurs reprises au MIT.

Récompenses et honneurs

Bertsekas a reçu le prix INFORMS 1997 pour l'excellence de la recherche sur l'interface entre la recherche opérationnelle et l' informatique pour son livre "Neuro-Dynamic Programming" (co-écrit avec John N. Tsitsiklis ); le prix national grec 2000 pour la recherche opérationnelle ; et le 2001 ACC John R. Ragazzini Education Award pour des contributions exceptionnelles à l'éducation. En 2001, il a été élu à l' Académie nationale d'ingénierie des États-Unis pour « contributions pionnières à la recherche fondamentale, à la pratique et à l'enseignement de la théorie de l' optimisation / contrôle , et en particulier de son application aux réseaux de communication de données ». En 2009, il a reçu le 2009 INFORMS Expository Writing Award pour sa capacité à « communiquer des concepts mathématiques difficiles avec une clarté inhabituelle, atteignant ainsi un large public dans de nombreuses disciplines. » En 2014, il a reçu le Richard E. Bellman Control Heritage Award de l' American Conseil de contrôle automatique , le prix Khachiyan pour les réalisations de toute une vie dans le domaine de l'optimisation de la société d'optimisation INFORMS. Il a également reçu le prix Dantzig 2015 du SIAM et de la Mathematical Optimization Society, le 2018 INFORMS John von Neumann Theory Prize (conjointement avec Tsitsiklis) pour les livres "Neuro-Dynamic Programming" et "Parallel and Distributed Algorithms", et le 2022 IEEE Control Systems Award pour « contributions fondamentales à la méthodologie d'optimisation et de contrôle » et « monographies et manuels exceptionnels ».

Manuels et monographies de recherche

Les manuels de Bertsekas comprennent

- Programmation dynamique et contrôle optimal (1996)

- Réseaux de données (1989, co-écrit avec Robert G. Gallager )

- Programmation non linéaire (1996)

- Introduction to Probability (2003, co-écrit avec John N. Tsitsiklis )

- Algorithmes d'optimisation convexe (2015)

qui sont tous utilisés pour l'enseignement en classe au MIT. Certains de ces livres ont été publiés en plusieurs éditions et ont été traduits dans diverses langues étrangères.

Il a également écrit plusieurs monographies de recherche , qui contiennent collectivement la plupart de ses recherches. Ceux-ci inclus:

- "Contrôle optimal stochastique: le cas en temps discret" (1978, co-écrit avec SE Shreve), un ouvrage mathématiquement complexe, établissant les fondements théoriques de la mesure de la programmation dynamique et du contrôle stochastique .

- "Constrained Optimization and Lagrange Multiplier Methods" (1982), la première monographie qui aborde de manière exhaustive les problèmes de convergence algorithmique autour des méthodes de programmation Lagrangienne augmentée et quadratique séquentielle .

- "Parallel and Distributed Computation: Numerical Methods" (1989, co-écrit avec John N. Tsitsiklis ), qui, entre autres, a établi les structures théoriques fondamentales pour l'analyse des algorithmes asynchrones distribués.

- "Linear Network Optimization" (1991) et "Network Optimization: Continuous and Discrete Models" (1998), qui, entre autres, discutent en détail de la classe d' algorithmes d'enchères pour l' affectation et l' optimisation des flux de réseau , développés par Bertsekas sur une période de 20 ans à partir de 1979.

- "Programmation neuro-dynamique" (1996, co-écrit avec Tsitsiklis), qui a jeté les bases théoriques d'approximations sous-optimales de problèmes de prise de décision séquentielle très complexes.

- "Convex Analysis and Optimization" (2003, co-écrit avec A. Nedic et A. Ozdaglar) et Convex Optimization Theory (2009), qui a fourni une nouvelle ligne de développement pour la théorie de la dualité d'optimisation, une nouvelle connexion entre la théorie des multiplicateurs de Lagrange et une analyse non lisse, et un développement complet de méthodes de sous-gradient incrémentiel .

- "Abstract Dynamic Programming" (2013), qui vise à un développement unifié de la théorie de base et des algorithmes des problèmes de décision séquentielle à coût total, basé sur les liens étroits du sujet avec la théorie du point fixe. Une 2e édition de cette monographie, qui reprend l'essentiel de ses recherches sur la programmation dynamique sur la période 2013-2017, est parue en 2018.

Ses dernières monographies de recherche sont Reinforcement Learning and Optimal Control (2019), qui vise à explorer la frontière commune entre la programmation dynamique/le contrôle optimal et l'intelligence artificielle, et à former un pont accessible aux travailleurs ayant une formation dans l'un ou l'autre domaine, et Rollout, Itération des politiques et apprentissage par renforcement distribué (2020), qui se concentre sur l'idée fondamentale de l'itération des politiques, son déploiement équivalent à une itération et leurs implémentations distribuées et multi-agents. Certaines de ces méthodes ont été à la base de succès de grande envergure dans des jeux tels que les échecs, le go et le backgammon.

Voir également

Les références

Liens externes

- Publications de Google Scholar .

- Publications de DBLP .

- Biographie de l'Académie nationale d'ingénierie

- Page d'accueil de Bertsekas au MIT

- Athéna Scientifique

- Laboratoire des systèmes d'information et de contrôle, MIT

- Département de génie électrique et informatique, MIT

- Biographie de Dimitri Bertsekas de l'Institut de recherche opérationnelle et des sciences de gestion (INFORMS)