Introduction à la mécanique quantique - Introduction to quantum mechanics

| Fait partie d'une série d'articles sur |

| Mécanique quantique |

|---|

La mécanique quantique est l'étude de très petites choses. Il explique le comportement de la matière et de ses interactions avec l' énergie sur l' échelle des atomes et des particules subatomiques . En revanche, la physique classique n'explique la matière et l'énergie qu'à une échelle familière à l'expérience humaine, y compris le comportement des corps astronomiques tels que la Lune. La physique classique est encore utilisée dans une grande partie de la science et de la technologie modernes. Cependant, vers la fin du 19ème siècle, les scientifiques ont découvert des phénomènes dans le grand ( macro ) et le petit ( micro ) monde que la physique classique ne pouvait pas expliquer. Le désir de résoudre les incohérences entre les phénomènes observés et la théorie classique a conduit à deux révolutions majeures en physique qui ont créé un changement dans le paradigme scientifique d'origine : la théorie de la relativité et le développement de la mécanique quantique . Cet article décrit comment les physiciens ont découvert les limites de la physique classique et développé les principaux concepts de la théorie quantique qui l'ont remplacée dans les premières décennies du 20e siècle. Il décrit ces concepts à peu près dans l'ordre dans lequel ils ont été découverts pour la première fois. Pour une histoire plus complète du sujet, voir Histoire de la mécanique quantique .

La lumière se comporte sous certains aspects comme des particules et sous d'autres aspects comme des ondes. Matter-la « substance » de l'univers constitué par des particules telles que les électrons et les atomes de comportement ondulatoire de trop. Certaines sources lumineuses, telles que les néons , n'émettent que certaines fréquences de lumière spécifiques, un petit ensemble de couleurs pures distinctes déterminées par la structure atomique du néon. La mécanique quantique montre que la lumière, ainsi que toutes les autres formes de rayonnement électromagnétique , se présente en unités discrètes, appelées photons , et prédit ses énergies spectrales (correspondant aux couleurs pures) et les intensités de ses faisceaux lumineux. Un photon unique est une particule quantique , ou la plus petite particule observable, du champ électromagnétique. Un photon partiel n'est jamais observé expérimentalement. Plus largement, la mécanique quantique montre que de nombreuses propriétés d'objets, telles que la position, la vitesse et le moment angulaire , qui semblaient continues dans la vue agrandie de la mécanique classique, s'avèrent être (dans la très petite échelle agrandie de mécanique quantique) quantifié . De telles propriétés de particules élémentaires doivent prendre l'une d'un ensemble de petites valeurs admissibles discrètes, et comme l'écart entre ces valeurs est également petit, les discontinuités ne sont apparentes qu'à de très petites échelles (atomiques).

De nombreux aspects de la mécanique quantique sont contre-intuitifs et peuvent sembler paradoxaux car ils décrivent un comportement assez différent de celui observé à plus grande échelle. Selon les mots du physicien quantique Richard Feynman , la mécanique quantique traite de "la nature telle qu'elle est—absurde".

Par exemple, le principe d'incertitude de la mécanique quantique signifie que plus on cerne une mesure (comme la position d'une particule), moins une autre mesure complémentaire relative à la même particule (comme sa vitesse ) doit devenir précise .

Un autre exemple est l' enchevêtrement , dans lequel une mesure de n'importe quel état à deux valeurs d'une particule (comme la lumière polarisée vers le haut ou vers le bas) effectuée sur l'une des deux particules « enchevêtrées » qui sont très éloignées entraîne une mesure ultérieure sur l'autre particule à toujours être l'autre des deux valeurs (comme polarisé dans le sens opposé).

Un dernier exemple est la superfluidité , dans laquelle un conteneur d'hélium liquide, refroidi à près du zéro absolu en température s'écoule spontanément (lentement) vers le haut et sur l'ouverture de son conteneur, contre la force de gravité.

La première théorie quantique : Max Planck et le rayonnement du corps noir

Le rayonnement thermique est un rayonnement électromagnétique émis par la surface d'un objet en raison de l'énergie interne de l'objet. Si un objet est suffisamment chauffé, il commence à émettre de la lumière à l'extrémité rouge du spectre , car il devient rouge chaud .

En le chauffant, la couleur passe du rouge au jaune, au blanc et au bleu, car elle émet de la lumière à des longueurs d'onde de plus en plus courtes (fréquences plus élevées). Un émetteur parfait est aussi un absorbeur parfait : lorsqu'il fait froid, un tel objet paraît parfaitement noir, car il absorbe toute la lumière qui lui tombe dessus et n'en émet aucune. Par conséquent, un émetteur thermique idéal est connu sous le nom de corps noir et le rayonnement qu'il émet est appelé rayonnement de corps noir .

À la fin du XIXe siècle, le rayonnement thermique avait été assez bien caractérisé expérimentalement. Cependant, la physique classique a conduit à la loi de Rayleigh-Jeans , qui, comme le montre la figure, est bien en accord avec les résultats expérimentaux aux basses fréquences, mais fortement en désaccord aux hautes fréquences. Les physiciens ont recherché une théorie unique qui expliquait tous les résultats expérimentaux.

Le premier modèle capable d'expliquer le spectre complet du rayonnement thermique a été proposé par Max Planck en 1900. Il a proposé un modèle mathématique dans lequel le rayonnement thermique était en équilibre avec un ensemble d' oscillateurs harmoniques . Pour reproduire les résultats expérimentaux, il a dû supposer que chaque oscillateur émettait un nombre entier d'unités d'énergie à sa fréquence caractéristique unique, plutôt que de pouvoir émettre une quantité arbitraire d'énergie. En d'autres termes, l'énergie émise par un oscillateur a été quantifiée . Le quantum d'énergie pour chaque oscillateur, selon Planck, était proportionnel à la fréquence de l'oscillateur ; la constante de proportionnalité est maintenant connue sous le nom de constante de Planck . La constante de Planck, généralement écrite comme h , a la valeur de6,63 × 10 -34 J s . Ainsi, l'énergie E d'un oscillateur de fréquence f est donnée par

Pour changer la couleur d'un tel corps rayonnant, il faut changer sa température. La loi de Planck explique pourquoi : augmenter la température d'un corps lui permet d'émettre globalement plus d'énergie, et signifie qu'une plus grande proportion de l'énergie se situe vers l'extrémité violette du spectre.

La loi de Planck a été la première théorie quantique en physique, et Planck a remporté le prix Nobel en 1918 « en reconnaissance des services qu'il a rendus à l'avancement de la physique par sa découverte des quanta d'énergie ». À l'époque, cependant, le point de vue de Planck était que la quantification était purement une construction mathématique heuristique, plutôt que (comme on le croit maintenant) un changement fondamental dans notre compréhension du monde.

Photons : la quantification de la lumière

En 1905, Albert Einstein franchit une étape supplémentaire. Il a suggéré que la quantification n'était pas seulement une construction mathématique, mais que l'énergie d'un faisceau de lumière se produit en fait dans des paquets individuels, qui sont maintenant appelés photons . L'énergie d'un seul photon de lumière de fréquence est donnée par la fréquence multipliée par la constante de Planck (un nombre positif extrêmement petit):

Pendant des siècles, les scientifiques ont débattu entre deux théories possibles de la lumière : était-ce une onde ou était-elle plutôt constituée d'un flux de minuscules particules ? Au XIXe siècle, le débat était généralement considéré comme résolu en faveur de la théorie des ondes, car elle était capable d'expliquer les effets observés tels que la réfraction , la diffraction , l' interférence et la polarisation . James Clerk Maxwell avait montré que l'électricité, le magnétisme et la lumière sont tous des manifestations du même phénomène : le champ électromagnétique . Les équations de Maxwell , qui sont l'ensemble complet des lois de l'électromagnétisme classique , décrivent la lumière comme des ondes : une combinaison de champs électriques et magnétiques oscillants. En raison de la prépondérance des preuves en faveur de la théorie des ondes, les idées d'Einstein ont été initialement accueillies avec un grand scepticisme. Finalement, cependant, le modèle photonique est devenu privilégié. L'un des éléments de preuve les plus significatifs en sa faveur était sa capacité à expliquer plusieurs propriétés déroutantes de l' effet photoélectrique , décrites dans la section suivante. Néanmoins, l'analogie ondulatoire restait indispensable pour aider à comprendre d'autres caractéristiques de la lumière : diffraction , réfraction et interférence .

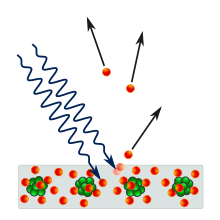

L'effet photoélectrique

En 1887, Heinrich Hertz a observé que lorsque la lumière avec une fréquence suffisante frappe une surface métallique, la surface émet des électrons. En 1902, Philipp Lenard découvre que l'énergie maximale possible d'un électron éjecté est liée à la fréquence de la lumière, pas à son intensité : si la fréquence est trop basse, aucun électron n'est éjecté quelle que soit l'intensité. Des faisceaux lumineux puissants vers l'extrémité rouge du spectre pourraient ne produire aucun potentiel électrique, tandis que des faisceaux lumineux faibles vers l'extrémité violette du spectre produiraient des tensions de plus en plus élevées. La fréquence de lumière la plus basse pouvant provoquer l'émission d'électrons, appelée fréquence de seuil, est différente pour différents métaux. Cette observation est en contradiction avec l'électromagnétisme classique, qui prédit que l'énergie de l'électron devrait être proportionnelle à l'intensité du rayonnement incident. Ainsi, lorsque les physiciens ont découvert pour la première fois des dispositifs présentant l'effet photoélectrique, ils s'attendaient initialement à ce qu'une intensité lumineuse plus élevée produise une tension plus élevée à partir du dispositif photoélectrique.

Einstein a expliqué l'effet en postulant qu'un faisceau de lumière est un flux de particules (" photons ") et que, si le faisceau est de fréquence f , alors chaque photon a une énergie égale à hf . Un électron n'est susceptible d'être frappé que par un seul photon, ce qui lui confère au plus une énergie hf . Par conséquent, l'intensité du faisceau n'a aucun effet et seule sa fréquence détermine l'énergie maximale qui peut être communiquée à l'électron.

Pour expliquer l'effet de seuil, Einstein a soutenu qu'il faut une certaine quantité d'énergie, appelée fonction de travail et notée φ , pour retirer un électron du métal. Cette quantité d'énergie est différente pour chaque métal. Si l'énergie du photon est inférieure à la fonction de sortie, alors il ne transporte pas suffisamment d'énergie pour retirer l'électron du métal. La fréquence seuil, f 0 , est la fréquence d'un photon dont l'énergie est égale au travail de sortie :

Si f est supérieur à f 0 , l'énergie hf est suffisante pour retirer un électron. L'électron éjecté a une énergie cinétique , E K , qui est au plus égale à l'énergie du photon moins l'énergie nécessaire pour déloger l'électron du métal :

La description d'Einstein de la lumière comme étant composée de particules a étendu la notion de Planck d'énergie quantifiée, qui est qu'un seul photon d'une fréquence donnée, f , délivre une quantité invariante d'énergie, hf . En d'autres termes, les photons individuels peuvent fournir plus ou moins d'énergie, mais uniquement en fonction de leurs fréquences. Dans la nature, les photons uniques sont rarement rencontrés. Le Soleil et les sources d'émission disponibles au 19ème siècle émettent un grand nombre de photons chaque seconde, et donc l'importance de l'énergie transportée par chaque photon n'était pas évidente. L'idée d'Einstein selon laquelle l'énergie contenue dans les unités individuelles de lumière dépend de leur fréquence a permis d'expliquer des résultats expérimentaux qui semblaient contre-intuitifs. Cependant, bien que le photon soit une particule, il était encore décrit comme ayant la propriété ondulatoire de la fréquence. En effet, la prise en compte de la lumière en tant que particule est insuffisante, et sa nature ondulatoire est toujours requise.

Conséquences de la quantification de la lumière

La relation entre la fréquence du rayonnement électromagnétique et l'énergie de chaque photon est la raison pour laquelle la lumière ultraviolette peut provoquer des coups de soleil , mais pas la lumière visible ou infrarouge . Un photon de lumière ultraviolette fournit une grande quantité d' énergie, suffisante pour contribuer aux dommages cellulaires, comme cela se produit lors d'un coup de soleil. Un photon de lumière infrarouge fournit moins d'énergie, juste assez pour réchauffer la peau. Ainsi, une lampe infrarouge peut réchauffer une grande surface, peut-être assez grande pour garder les gens à l'aise dans une pièce froide, mais elle ne peut donner à personne un coup de soleil.

Tous les photons de même fréquence ont une énergie identique, et tous les photons de fréquences différentes ont proportionnellement (ordre 1, E photon = hf ) des énergies différentes. Cependant, bien que l'énergie conférée par les photons soit invariante à une fréquence donnée, l'état énergétique initial des électrons dans un dispositif photoélectrique avant l'absorption de la lumière n'est pas nécessairement uniforme. Des résultats anormaux peuvent se produire dans le cas d'électrons individuels. Par exemple, un électron déjà excité au-dessus du niveau d'équilibre du dispositif photoélectrique peut être éjecté lorsqu'il absorbe un éclairage à basse fréquence inhabituel. Statistiquement, cependant, le comportement caractéristique d'un dispositif photoélectrique reflète le comportement de la grande majorité de ses électrons, qui sont à leur niveau d'équilibre. Ce point permet de clarifier la distinction entre l'étude des petites particules individuelles en dynamique quantique et l'étude des particules individuelles massives en physique classique.

La quantification de la matière : le modèle de Bohr de l'atome

À l'aube du 20e siècle, les preuves nécessitaient un modèle de l'atome avec un nuage diffus d' électrons chargés négativement entourant un petit noyau dense et chargé positivement . Ces propriétés suggèrent un modèle dans lequel les électrons entourent le noyau comme des planètes en orbite autour d'un soleil. Cependant, on savait aussi que l'atome dans ce modèle serait instable : selon la théorie classique, les électrons en orbite subissent une accélération centripète, et devraient donc émettre un rayonnement électromagnétique, la perte d'énergie les faisant également spiraler vers le noyau, se heurtant avec elle en une fraction de seconde.

Un deuxième casse-tête connexe était le spectre d'émission des atomes. Lorsqu'un gaz est chauffé, il n'émet de la lumière qu'à des fréquences discrètes. Par exemple, la lumière visible émise par l' hydrogène se compose de quatre couleurs différentes, comme le montre l'image ci-dessous. L'intensité de la lumière à différentes fréquences est également différente. En revanche, la lumière blanche consiste en une émission continue sur toute la gamme des fréquences visibles. À la fin du XIXe siècle, une règle simple connue sous le nom de formule de Balmer montrait comment les fréquences des différentes raies étaient liées les unes aux autres, mais sans expliquer pourquoi, ni faire de prédiction sur les intensités. La formule a également prédit certaines raies spectrales supplémentaires dans la lumière ultraviolette et infrarouge qui n'avaient pas été observées à l'époque. Ces lignes ont ensuite été observées expérimentalement, augmentant la confiance dans la valeur de la formule.

En 1885 , le mathématicien suisse Johann Balmer a découvert que chaque longueur d' onde λ (lambda) dans le spectre visible d'hydrogène est lié à un entier n par l'équation

où B est une constante de Balmer déterminée égale à 364,56 nm.

En 1888, Johannes Rydberg généralisa et augmenta considérablement l'utilité explicative de la formule de Balmer. Il a prédit que λ est lié à deux nombres entiers n et m selon ce qui est maintenant connu sous le nom de formule de Rydberg :

où R est la constante de Rydberg , égale à 0,0110 nm -1 , et n doit être supérieur à m .

La formule de Rydberg tient compte des quatre longueurs d'onde visibles de l'hydrogène en fixant m = 2 et n = 3, 4, 5, 6 . Il prédit également des longueurs d'onde supplémentaires dans le spectre d'émission : pour m = 1 et pour n > 1 , le spectre d'émission doit contenir certaines longueurs d'onde ultraviolettes, et pour m = 3 et n > 3 , il doit également contenir certaines longueurs d'onde infrarouges. L'observation expérimentale de ces longueurs d'onde a eu lieu deux décennies plus tard : en 1908, Louis Paschen a trouvé certaines des longueurs d'onde infrarouges prédites, et en 1914, Theodore Lyman a trouvé certaines des longueurs d'onde ultraviolettes prédites.

Les formules de Balmer et de Rydberg impliquent toutes deux des nombres entiers : en termes modernes, elles impliquent qu'une certaine propriété de l'atome est quantifiée. Comprendre exactement ce qu'était cette propriété, et pourquoi elle a été quantifiée, a été une partie importante du développement de la mécanique quantique, comme le montre la suite de cet article.

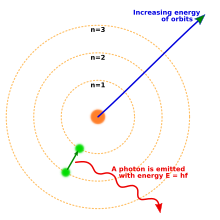

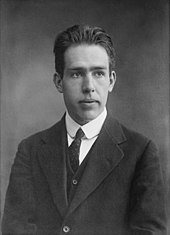

En 1913, Niels Bohr a proposé un nouveau modèle de l'atome qui comprenait des orbites d'électrons quantifiées : les électrons gravitent toujours autour du noyau comme les planètes tournent autour du soleil, mais ils ne sont autorisés à habiter que certaines orbites, et non à une distance arbitraire. Lorsqu'un atome émettait (ou absorbait) de l'énergie, l'électron ne se déplaçait pas selon une trajectoire continue d'une orbite autour du noyau à une autre, comme on pouvait s'y attendre classiquement. Au lieu de cela, l'électron sauterait instantanément d'une orbite à une autre, dégageant la lumière émise sous la forme d'un photon. Les énergies possibles des photons émis par chaque élément étaient déterminées par les différences d'énergie entre les orbites, et ainsi le spectre d'émission pour chaque élément contiendrait un certain nombre de raies.

Partant d'une seule hypothèse simple sur la règle selon laquelle les orbites doivent obéir, le modèle de Bohr a pu relier les raies spectrales observées dans le spectre d'émission de l'hydrogène à des constantes connues auparavant. Dans le modèle de Bohr, l'électron n'était pas autorisé à émettre de l'énergie en continu et à s'écraser sur le noyau : une fois qu'il était sur l'orbite autorisée la plus proche, il était stable pour toujours. Le modèle de Bohr n'expliquait pas pourquoi les orbites devaient être quantifiées de cette manière, ni n'était capable de faire des prédictions précises pour les atomes avec plus d'un électron, ou d'expliquer pourquoi certaines raies spectrales sont plus lumineuses que d'autres.

Certaines hypothèses fondamentales du modèle de Bohr se sont rapidement révélées fausses, mais le résultat clé selon lequel les raies discrètes dans les spectres d'émission sont dues à une propriété des électrons dans les atomes en cours de quantification est correct. La façon dont les électrons se comportent réellement est remarquablement différente de celle de l'atome de Bohr et de ce que nous voyons dans le monde de notre expérience quotidienne ; ce modèle moderne de mécanique quantique de l'atome est discuté ci - dessous .

Bohr a théorisé que le moment angulaire , L , d'un électron est quantifié:

où n est un entier et h est la constante de Planck. Partant de cette hypothèse, la loi de Coulomb et les équations du mouvement circulaire montrent qu'un électron avec n unités de moment cinétique orbite autour d'un proton à une distance r donnée par

- ,

où k e est la constante de Coulomb , m est la masse d'un électron et e est la charge d'un électron . Pour plus de simplicité, cela s'écrit

où un 0 , appelé rayon de Bohr , est égal à 0,0529 nm. Le rayon de Bohr est le rayon de la plus petite orbite autorisée.

L'énergie de l'électron peut également être calculée, et est donnée par

- .

Ainsi, l'hypothèse de Bohr selon laquelle le moment angulaire est quantifié signifie qu'un électron ne peut habiter que certaines orbites autour du noyau et qu'il ne peut avoir que certaines énergies. Une conséquence de ces contraintes est que l'électron ne s'écrase pas sur le noyau : il ne peut pas émettre d'énergie en continu, et il ne peut pas se rapprocher du noyau plus qu'un 0 (le rayon de Bohr).

Un électron perd de l'énergie en sautant instantanément de son orbite d'origine à une orbite inférieure ; l'énergie supplémentaire est émise sous la forme d'un photon. Inversement, un électron qui absorbe un photon gagne de l'énergie, il saute donc sur une orbite plus éloignée du noyau.

Chaque photon de l'hydrogène atomique incandescent est dû à un électron se déplaçant d'une orbite supérieure, de rayon r n , à une orbite inférieure, r m . L'énergie E γ de ce photon est la différence des énergies E n et E m de l'électron :

Etant donné que l' équation de Planck spectacles que l'énergie du photon est liée à sa longueur d' onde par E γ = hc / λ , la longueur d' onde de la lumière qui peuvent être émises sont donnés par

Cette équation a la même forme que la formule de Rydberg et prédit que la constante R doit être donnée par

Par conséquent, le modèle de Bohr de l'atome peut prédire le spectre d'émission de l'hydrogène en termes de constantes fondamentales. Cependant, il n'a pas été en mesure de faire des prédictions précises pour les atomes multi-électrons, ou d'expliquer pourquoi certaines raies spectrales sont plus lumineuses que d'autres.

Dualité onde-particule

Tout comme la lumière a à la fois des propriétés ondulatoires et particulaires, la matière a également des propriétés ondulatoires .

La matière se comportant comme une onde a d'abord été démontrée expérimentalement pour les électrons : un faisceau d'électrons peut présenter une diffraction , tout comme un faisceau de lumière ou une onde d'eau. Des phénomènes ondulatoires similaires ont été montrés plus tard pour les atomes et même les molécules.

La longueur d' onde, λ , associée à un objet est en relation avec son élan, p , par la constante de Planck , h :

La relation, appelée hypothèse de de Broglie, vaut pour tous les types de matière : toute matière présente des propriétés à la fois de particules et d'ondes.

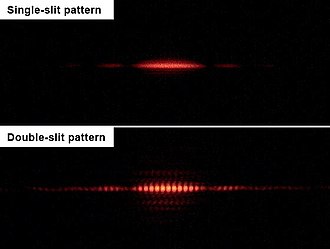

Le concept de dualité onde-particule dit que ni le concept classique de « particule » ni d'« onde » ne peut décrire complètement le comportement des objets à l'échelle quantique, que ce soit des photons ou de la matière. La dualité onde-particule est un exemple du principe de complémentarité en physique quantique. Un exemple élégant de dualité onde-particule, l'expérience à double fente, est discuté dans la section ci-dessous.

L'expérience de la double fente

Dans l'expérience à double fente, réalisée à l'origine par Thomas Young en 1803, puis par Augustin Fresnel une décennie plus tard, un faisceau de lumière est dirigé à travers deux fentes étroites et rapprochées, produisant un motif d'interférence de bandes claires et sombres sur un écran . Si l'une des fentes est recouverte, on pourrait naïvement s'attendre à ce que l'intensité des franges due aux interférences soit partout divisée par deux. En fait, un motif beaucoup plus simple est observé, un motif de diffraction diamétralement opposé à la fente ouverte. Le même comportement peut être démontré dans les vagues d'eau, et l'expérience à double fente a donc été considérée comme une démonstration de la nature ondulatoire de la lumière.

Des variations de l'expérience à double fente ont été réalisées en utilisant des électrons, des atomes et même de grosses molécules, et le même type de motif d'interférence est observé. Ainsi, il a été démontré que toute matière possède à la fois des caractéristiques de particules et d'ondes.

Même si l'intensité de la source est réduite, de sorte qu'une seule particule (par exemple un photon ou un électron) traverse l'appareil à la fois, le même motif d'interférence se développe avec le temps. La particule quantique agit comme une onde lorsqu'elle traverse les doubles fentes, mais comme une particule lorsqu'elle est détectée. C'est une caractéristique typique de la complémentarité quantique : une particule quantique agit comme une onde dans une expérience pour mesurer ses propriétés ondulatoires, et comme une particule dans une expérience pour mesurer ses propriétés comme des particules. Le point sur l'écran du détecteur où une particule individuelle apparaît est le résultat d'un processus aléatoire. Cependant, le schéma de distribution de nombreuses particules individuelles imite le schéma de diffraction produit par les ondes.

Application au modèle de Bohr

De Broglie a développé le modèle de Bohr de l'atome en montrant qu'un électron en orbite autour d'un noyau pouvait être considéré comme ayant des propriétés ondulatoires. En particulier, un électron n'est observé que dans des situations qui permettent une onde stationnaire autour d'un noyau . Un exemple d'onde stationnaire est une corde de violon, qui est fixée aux deux extrémités et peut être mise en vibration. Les vagues créées par un instrument à cordes semblent osciller sur place, se déplaçant de crête en creux dans un mouvement de haut en bas. La longueur d'onde d'une onde stationnaire est liée à la longueur de l'objet vibrant et aux conditions aux limites. Par exemple, comme la corde du violon est fixée aux deux extrémités, elle peut transporter des ondes stationnaires de longueurs d'onde , où l est la longueur et n est un entier positif. De Broglie a suggéré que les orbites d'électrons autorisées étaient celles pour lesquelles la circonférence de l'orbite serait un nombre entier de longueurs d'onde. La longueur d'onde de l'électron détermine donc que seules les orbites de Bohr à certaines distances du noyau sont possibles. À son tour, à n'importe quelle distance du noyau inférieure à une certaine valeur, il serait impossible d'établir une orbite. La distance minimale possible du noyau est appelée rayon de Bohr.

Le traitement des événements quantiques par De Broglie a servi de point de départ à Schrödinger lorsqu'il a entrepris de construire une équation d'onde pour décrire les événements de la théorie quantique.

Tournoyer

En 1922, Otto Stern et Walther Gerlach ont projeté des atomes d'argent à travers un champ magnétique inhomogène . Par rapport à son pôle nord, pointant vers le haut, le bas ou quelque part entre les deux, en mécanique classique, un aimant projeté à travers un champ magnétique peut être dévié sur une petite ou grande distance vers le haut ou vers le bas. Les atomes que Stern et Gerlach ont projetés à travers le champ magnétique ont agi de la même manière. Cependant, alors que les aimants pourraient être déviés à des distances variables, les atomes seraient toujours déviés à une distance constante vers le haut ou vers le bas. Cela impliquait que la propriété de l'atome qui correspond à l'orientation de l'aimant doit être quantifiée, en prenant l'une des deux valeurs (vers le haut ou vers le bas), au lieu d'être choisie librement sous n'importe quel angle.

Ralph Kronig est à l'origine de la théorie selon laquelle les particules telles que les atomes ou les électrons se comportent comme si elles tournaient ou "tournaient" autour d'un axe. Le spin expliquerait le moment magnétique manquant et permettrait à deux électrons dans la même orbitale d'occuper des états quantiques distincts s'ils "tournaient" dans des directions opposées, satisfaisant ainsi le principe d'exclusion . Le nombre quantique représentait le sens (positif ou négatif) du spin.

Le choix de l'orientation du champ magnétique utilisé dans l'expérience de Stern-Gerlach est arbitraire. Dans l'animation montrée ici, le champ est vertical et les atomes sont donc déviés vers le haut ou vers le bas. Si l'aimant est tourné d'un quart de tour, les atomes sont déviés vers la gauche ou vers la droite. L'utilisation d'un champ vertical montre que le spin le long de l'axe vertical est quantifié, et l'utilisation d'un champ horizontal montre que le spin le long de l'axe horizontal est quantifié.

Si au lieu de frapper un écran de détecteur, l'un des faisceaux d'atomes sortant de l'appareil Stern-Gerlach est passé dans un autre champ magnétique (inhomogène) orienté dans la même direction, tous les atomes sont déviés de la même manière dans ce second champ . Cependant, si le second champ est orienté à 90° par rapport au premier, alors la moitié des atomes sont déviés dans un sens et l'autre dans l'autre de sorte que le spin de l'atome autour des axes horizontal et vertical soit indépendant l'un de l'autre. Cependant, si l'un de ces faisceaux (par exemple les atomes qui ont été déviés vers le haut puis vers la gauche) est passé dans un troisième champ magnétique, orienté de la même manière que le premier, la moitié des atomes vont dans un sens et l'autre dans l'autre, même s'ils sont tous allait dans le même sens à l'origine. L'action de mesurer le spin des atomes concernant un champ horizontal a changé leur spin concernant un champ vertical.

L'expérience Stern-Gerlach démontre plusieurs caractéristiques importantes de la mécanique quantique :

- Il a été démontré qu'une caractéristique du monde naturel est quantifiée et ne peut prendre que certaines valeurs discrètes.

- Les particules possèdent un moment angulaire intrinsèque qui est étroitement analogue au moment angulaire d'un objet en rotation classique.

- La mesure modifie le système mesuré en mécanique quantique. Seule la rotation d'un objet dans une direction peut être connue, et l'observation de la rotation dans une autre direction détruit les informations originales sur la rotation.

- La mécanique quantique est probabiliste : que le spin d'un atome individuel envoyé dans l'appareil soit positif ou négatif est aléatoire.

Développement de la mécanique quantique moderne

En 1925, Werner Heisenberg tenta de résoudre l'un des problèmes que le modèle de Bohr laissait sans réponse, expliquant les intensités des différentes raies du spectre d'émission d'hydrogène. À travers une série d'analogies mathématiques, il a écrit l'analogue de la mécanique quantique pour le calcul classique des intensités. Peu de temps après, le collègue de Heisenberg, Max Born, s'est rendu compte que la méthode de Heisenberg de calcul des probabilités de transition entre les différents niveaux d'énergie pouvait être mieux exprimée en utilisant le concept mathématique de matrices .

La même année, s'appuyant sur l'hypothèse de de Broglie, Erwin Schrödinger développa l'équation qui décrit le comportement d'une onde de mécanique quantique. Le modèle mathématique, appelé équation de Schrödinger d' après son créateur, est au cœur de la mécanique quantique, définit les états stationnaires autorisés d'un système quantique et décrit comment l'état quantique d'un système physique change dans le temps. L'onde elle-même est décrite par une fonction mathématique appelée « fonction d'onde ». Schrödinger a déclaré que la fonction d'onde fournit "les moyens de prédire la probabilité des résultats de mesure".

Schrödinger a pu calculer les niveaux d'énergie de l'hydrogène en traitant l' électron d'un atome d'hydrogène comme une onde classique, se déplaçant dans un puits du potentiel électrique créé par le proton. Ce calcul a reproduit avec précision les niveaux d'énergie du modèle de Bohr.

En mai 1926, Schrödinger prouva que la mécanique matricielle de Heisenberg et sa propre mécanique ondulatoire faisaient les mêmes prédictions sur les propriétés et le comportement de l'électron ; mathématiquement, les deux théories avaient une forme commune sous-jacente. Pourtant, les deux hommes étaient en désaccord sur l'interprétation de leur théorie mutuelle. Par exemple, Heisenberg a accepté la prédiction théorique des sauts d'électrons entre les orbitales d'un atome, mais Schrödinger espérait qu'une théorie basée sur des propriétés ondulatoires continues pourrait éviter ce qu'il a appelé (comme paraphrasé par Wilhelm Wien ) "ce non-sens sur les sauts quantiques" . Au final, l'approche d'Heisenberg l'a emporté et les sauts quantiques ont été confirmés.

Interprétation de Copenhague

Bohr, Heisenberg et d'autres ont essayé d'expliquer ce que signifient réellement ces résultats expérimentaux et ces modèles mathématiques. Leur description, connue sous le nom d'interprétation de Copenhague de la mécanique quantique, visait à décrire la nature de la réalité qui était sondée par les mesures et décrite par les formulations mathématiques de la mécanique quantique.

Les grands principes de l'interprétation de Copenhague sont :

- Un système est complètement décrit par une fonction d'onde , généralement représentée par la lettre grecque ("psi"). (Heisenberg)

- L' équation de Schrödinger donne l'évolution dans le temps.

- La description de la nature est essentiellement probabiliste. La probabilité d'un événement - par exemple, où sur l'écran une particule apparaît dans l'expérience à double fente - est liée au carré de la valeur absolue de l'amplitude de sa fonction d'onde. ( Règle de Born , due à Max Born , qui donne un sens physique à la fonction d'onde dans l'interprétation de Copenhague : l' amplitude de probabilité )

- Il n'est pas possible de connaître les valeurs de toutes les propriétés du système en même temps ; les propriétés qui ne sont pas connues avec précision doivent être décrites par des probabilités. (principe d' incertitude de Heisenberg )

- La matière, comme l'énergie, présente une dualité onde-particule. Une expérience peut démontrer les propriétés particulaires de la matière, ou ses propriétés ondulatoires ; mais pas les deux à la fois. ( Principe de complémentarité dû à Bohr)

- Les appareils de mesure sont essentiellement des appareils classiques et mesurent des propriétés classiques telles que la position et la quantité de mouvement.

- La description de la mécanique quantique des grands systèmes devrait se rapprocher étroitement de la description classique. ( Principe de correspondance de Bohr et Heisenberg)

Diverses conséquences de ces principes sont examinées plus en détail dans les sous-sections suivantes.

Principe incertain

Supposons que l'on souhaite mesurer la position et la vitesse d'un objet, par exemple une voiture passant à travers un radar radar. On peut supposer que la voiture a une position et une vitesse définies à un moment donné. La précision avec laquelle ces valeurs peuvent être mesurées dépend de la qualité de l'équipement de mesure. Si la précision de l'équipement de mesure est améliorée, elle fournit un résultat plus proche de la vraie valeur. On pourrait supposer que la vitesse de la voiture et sa position pourraient être définies et mesurées de manière opérationnelle simultanément, aussi précisément que l'on pourrait le souhaiter.

En 1927, Heisenberg a prouvé que cette dernière hypothèse n'est pas correcte. La mécanique quantique montre que certaines paires de propriétés physiques, par exemple la position et la vitesse, ne peuvent pas être simultanément mesurées, ni définies en termes opérationnels, avec une précision arbitraire : plus une propriété est mesurée avec précision, ou définie en termes opérationnels, moins L'autre. Cette déclaration est connue sous le nom de principe d'incertitude . Le principe d'incertitude n'est pas seulement une déclaration sur la précision de notre équipement de mesure, mais, plus profondément, sur la nature conceptuelle des quantités mesurées - l'hypothèse selon laquelle la voiture avait défini simultanément la position et la vitesse ne fonctionne pas en mécanique quantique. À l'échelle des voitures et des personnes, ces incertitudes sont négligeables, mais lorsqu'il s'agit d'atomes et d'électrons, elles deviennent critiques.

Heisenberg a donné, à titre d'illustration, la mesure de la position et de la quantité de mouvement d'un électron à l'aide d'un photon de lumière. En mesurant la position de l'électron, plus la fréquence du photon est élevée, plus la mesure de la position de l'impact du photon avec l'électron est précise, mais plus la perturbation de l'électron est importante. En effet, à partir de l'impact avec le photon, l'électron absorbe une quantité aléatoire d'énergie, rendant la mesure obtenue de sa quantité de mouvement de plus en plus incertaine (la quantité de mouvement est la vitesse multipliée par la masse), car on mesure nécessairement sa quantité de mouvement perturbée post-impact à partir de la produits de collision et non son impulsion d'origine (impulsion qui doit être mesurée simultanément avec la position). Avec un photon de fréquence inférieure, la perturbation (et donc l'incertitude) de la quantité de mouvement est moindre, mais la précision de la mesure de la position de l'impact l'est également.

Au cœur du principe d'incertitude se trouve le fait que pour toute analyse mathématique dans les domaines de la position et de la vitesse, l'obtention d'une courbe plus nette (plus précise) dans le domaine de la position ne peut se faire qu'au détriment d'une courbe plus progressive (moins précise). dans le domaine de la vitesse, et vice versa. Plus de netteté dans le domaine de la position nécessite des contributions de plus de fréquences dans le domaine de la vitesse pour créer la courbe la plus étroite, et vice versa. C'est un compromis fondamental inhérent à de telles mesures connexes ou complémentaires , mais n'est vraiment perceptible qu'à la plus petite échelle (Planck), proche de la taille des particules élémentaires .

Le principe d'incertitude montre mathématiquement que le produit de l'incertitude sur la position et la quantité de mouvement d'une particule (la quantité de mouvement est la vitesse multipliée par la masse) ne pourrait jamais être inférieur à une certaine valeur, et que cette valeur est liée à la constante de Planck .

Effondrement de la fonction d'onde

L'effondrement de la fonction d'onde signifie qu'une mesure a forcé ou converti un état quantique (probabiliste ou potentiel) en une valeur mesurée définie. Ce phénomène ne se voit qu'en mécanique quantique plutôt qu'en mécanique classique.

Par exemple, avant qu'un photon "apparaisse" réellement sur un écran de détection, il ne peut être décrit qu'avec un ensemble de probabilités pour l'endroit où il pourrait apparaître. Lorsqu'il apparaît, par exemple dans le CCD d'une caméra électronique, le temps et l'espace où il a interagi avec l'appareil sont connus dans des limites très strictes. Cependant, le photon a disparu en cours de capture (mesure) et sa fonction d'onde quantique a disparu avec lui. A sa place, un changement physique macroscopique dans l'écran de détection est apparu, par exemple, une tache exposée dans une feuille de film photographique, ou un changement de potentiel électrique dans une cellule d'un CCD.

États propres et valeurs propres

En raison du principe d'incertitude , les déclarations concernant à la fois la position et la quantité de mouvement des particules ne peuvent attribuer qu'une probabilité que la position ou la quantité de mouvement ait une valeur numérique. Par conséquent, il est nécessaire de formuler clairement la différence entre l'état de quelque chose d'indéterminé, tel qu'un électron dans un nuage de probabilité, et l'état de quelque chose ayant une valeur définie. Lorsqu'un objet peut définitivement être "fixé" à certains égards, on dit qu'il possède un état propre .

Dans l'expérience Stern-Gerlach discutée ci - dessus , le spin de l'atome autour de l'axe vertical a deux états propres : haut et bas. Avant de le mesurer, nous pouvons seulement dire que tout atome individuel a une probabilité égale d'avoir un spin up ou un spin down. Le processus de mesure provoque l'effondrement de la fonction d'onde dans l'un des deux états.

Les états propres de spin autour de l'axe vertical ne sont pas simultanément des états propres de spin autour de l'axe horizontal, de sorte que cet atome a une probabilité égale d'avoir l'une ou l'autre valeur de spin autour de l'axe horizontal. Comme décrit dans la section ci - dessus , la mesure du spin autour de l'axe horizontal peut permettre à un atome qui a été tourné vers le haut de tourner vers le bas : la mesure de son spin autour de l'axe horizontal réduit sa fonction d'onde dans l'un des états propres de cette mesure, ce qui signifie qu'il est n'étant plus dans un état propre de spin autour de l'axe vertical, il peut donc prendre l'une ou l'autre valeur.

Le principe d'exclusion de Pauli

En 1924, Wolfgang Pauli proposa un nouveau degré de liberté quantique (ou nombre quantique ), avec deux valeurs possibles, pour résoudre les incohérences entre les spectres moléculaires observés et les prédictions de la mécanique quantique. En particulier, le spectre de l'hydrogène atomique avait un doublet , ou une paire de raies différant légèrement, où une seule raie était attendue. Pauli a formulé son principe d'exclusion en déclarant : « Il ne peut pas exister un atome dans un état quantique tel que deux électrons à l'intérieur [il] aient le même ensemble de nombres quantiques ».

Un an plus tard, Uhlenbeck et Goudsmit ont identifié le nouveau degré de liberté de Pauli avec la propriété appelée spin dont les effets ont été observés dans l'expérience Stern-Gerlach.

Application à l'atome d'hydrogène

Le modèle de Bohr de l'atome était essentiellement un modèle planétaire, avec les électrons en orbite autour du « soleil » nucléaire. Cependant, le principe d'incertitude stipule qu'un électron ne peut pas avoir simultanément une position et une vitesse exactes de la même manière qu'une planète. Au lieu des orbites classiques, on dit que les électrons habitent les orbitales atomiques . Une orbitale est le "nuage" d'emplacements possibles dans lesquels un électron pourrait être trouvé, une distribution de probabilités plutôt qu'un emplacement précis. Chaque orbitale est tridimensionnelle, plutôt que l'orbite bidimensionnelle, et est souvent décrite comme une région tridimensionnelle dans laquelle il y a une probabilité de 95 pour cent de trouver l'électron.

Schrödinger a été capable de calculer les niveaux d'énergie de l' hydrogène par traitement d' un atome d'hydrogène de l'électron sous forme d'onde, représentée par la « fonction d'onde » Ψ , dans un potentiel électrique bien , V , créé par le proton. Les solutions de l'équation de Schrödinger sont des distributions de probabilités pour les positions et les emplacements des électrons. Les orbitales ont une gamme de formes différentes en trois dimensions. Les énergies des différentes orbitales peuvent être calculées et elles correspondent avec précision aux niveaux d'énergie du modèle de Bohr.

Dans l'image de Schrödinger, chaque électron a quatre propriétés :

- Une désignation « orbitale », indiquant si l'onde particulaire est une onde plus proche du noyau avec moins d'énergie ou une onde plus éloignée du noyau avec plus d'énergie ;

- La "forme" de l'orbitale, sphérique ou autre;

- L'« inclinaison » de l'orbitale, déterminant le moment magnétique de l'orbitale autour de l' axe z .

- Le "spin" de l'électron.

Le nom collectif de ces propriétés est l' état quantique de l'électron. L'état quantique peut être décrit en donnant un numéro à chacune de ces propriétés ; ceux-ci sont connus comme les nombres quantiques de l'électron . L'état quantique de l'électron est décrit par sa fonction d'onde. Le principe d'exclusion de Pauli exige qu'aucun électron d'un atome ne puisse avoir les mêmes valeurs des quatre nombres.

La première propriété décrivant l'orbitale est le nombre quantique principal , n , qui est le même que dans le modèle de Bohr. n désigne le niveau d'énergie de chaque orbitale. Les valeurs possibles pour n sont des entiers :

Le nombre quantique suivant, le nombre quantique azimutal , noté l , décrit la forme de l'orbitale. La forme est une conséquence du moment cinétique de l'orbitale. Le moment angulaire représente la résistance d'un objet en rotation à accélérer ou à ralentir sous l'influence d'une force externe. Le nombre quantique azimutal représente le moment angulaire orbital d'un électron autour de son noyau. Les valeurs possibles pour l sont des nombres entiers de 0 à n − 1 (où n est le nombre quantique principal de l'électron) :

La forme de chaque orbitale est généralement désignée par une lettre plutôt que par son nombre quantique azimutal. La première forme ( L = 0) est désigné par la lettre de (a mnémonique « être s de phère »). La forme suivante est désignée par la lettre p et a la forme d'un haltère. Les autres orbitales ont des formes plus compliquées (voir orbitale atomique ), et sont désignées par les lettres d , f , g , etc.

Le troisième nombre quantique, le nombre quantique magnétique , décrit le moment magnétique de l'électron, et est noté m l (ou simplement m ). Les valeurs possibles pour m l sont des nombres entiers de − l à l (où l est le nombre quantique azimutal de l'électron) :

Le nombre quantique magnétique mesure la composante du moment cinétique dans une direction particulière. Le choix de la direction est arbitraire ; conventionnellement, la direction z est choisie.

Le quatrième nombre quantique, le nombre quantique de rotation ( se rapportant à « orientation » de spin de l'électron) est noté m s , avec des valeurs + 1 / 2 ou - 1 / 2 .

Le chimiste Linus Pauling a écrit, à titre d'exemple :

Dans le cas d'un atome d' hélium avec deux électrons dans l' orbitale 1 s , le principe d'exclusion de Pauli exige que les deux électrons diffèrent par la valeur d'un nombre quantique. Leurs valeurs de n , l et m l sont les mêmes. En conséquence , ils doivent être différents de la valeur de m s , qui peut avoir la valeur de + 1 / 2 pour un électron et - 1 / 2 pour l'autre « .

C'est la structure sous-jacente et la symétrie des orbitales atomiques, et la façon dont les électrons les remplissent, qui conduisent à l'organisation du tableau périodique . La façon dont les orbitales atomiques sur différents atomes se combinent pour former des orbitales moléculaires détermine la structure et la force des liaisons chimiques entre les atomes.

Équation d'onde de Dirac

En 1928, Paul Dirac a étendu l' équation de Pauli , qui décrit les électrons en rotation, pour tenir compte de la relativité restreinte . Le résultat était une théorie qui traitait correctement des événements, tels que la vitesse à laquelle un électron orbite autour du noyau, se produisant à une fraction substantielle de la vitesse de la lumière . En utilisant l' interaction électromagnétique la plus simple , Dirac a pu prédire la valeur du moment magnétique associé au spin de l'électron et a trouvé la valeur observée expérimentalement, qui était trop grande pour être celle d'une sphère chargée en rotation régie par la physique classique . Il était capable de résoudre les raies spectrales de l'atome d'hydrogène et de reproduire à partir des premiers principes physiques la formule réussie de Sommerfeld pour la structure fine du spectre de l'hydrogène.

Les équations de Dirac donnaient parfois une valeur négative pour l'énergie, pour laquelle il proposait une nouvelle solution : il postulait l'existence d'un antiélectron et d'un vide dynamique. Cela a conduit à la théorie des champs quantiques à plusieurs particules .

Intrication quantique

Le principe d'exclusion de Pauli dit que deux électrons dans un système ne peuvent pas être dans le même état. La nature laisse cependant ouverte la possibilité que deux électrons puissent avoir les deux états "superposés" sur chacun d'eux. Rappelons que les fonctions d'onde qui émergent simultanément des doubles fentes arrivent à l'écran de détection dans un état de superposition. Rien n'est certain jusqu'à ce que les formes d'onde superposées "s'effondrent". À cet instant, un électron apparaît quelque part selon la probabilité qui est le carré de la valeur absolue de la somme des amplitudes à valeurs complexes des deux formes d'onde superposées. La situation y est déjà très abstraite. Une façon concrète de penser les photons intriqués, photons dans lesquels deux états contraires se superposent à chacun d'eux dans le même événement, est la suivante :

Imaginez que nous ayons deux états de photons codés par couleur : un état étiqueté bleu et un autre état étiqueté rouge . Que la superposition de l'état rouge et bleu apparaisse (en imagination) comme un état violet . Nous considérons un cas dans lequel deux photons sont produits à la suite d'un seul événement atomique. Peut-être sont-ils produits par l'excitation d'un cristal qui absorbe de manière caractéristique un photon d'une certaine fréquence et émet deux photons de la moitié de la fréquence d'origine. Dans ce cas, les photons sont interconnectés via leur origine commune dans un seul événement atomique. Cette configuration se traduit par des états superposés des photons. Les deux photons sortent donc violets. Si l'expérimentateur effectue maintenant une expérience qui détermine si l'un des photons est bleu ou rouge , alors cette expérience change le photon impliqué d'un photon ayant une superposition de caractéristiques bleues et rouges à un photon qui n'a qu'une de ces caractéristiques. Le problème qu'Einstein a eu avec une telle situation imaginée était que si l'un de ces photons avait été maintenu à rebondir entre les miroirs d'un laboratoire sur terre, et que l'autre avait voyagé à mi-chemin vers l'étoile la plus proche lorsque son jumeau a été amené à se révéler soit comme bleu ou rouge, cela signifiait que le photon distant devait maintenant perdre également son statut violet . Ainsi, chaque fois qu'il pourrait être étudié après que son jumeau ait été mesuré, il apparaîtrait nécessairement dans l'état opposé à ce que son jumeau avait révélé.

En essayant de montrer que la mécanique quantique n'était pas une théorie complète, Einstein a commencé par la prédiction de la théorie selon laquelle deux particules ou plus qui ont interagi dans le passé peuvent apparaître fortement corrélées lorsque leurs diverses propriétés sont ensuite mesurées. Il a cherché à expliquer cette interaction apparente de manière classique, à travers leur passé commun, et de préférence pas par une "action effrayante à distance". L'argument est élaboré dans un article célèbre, Einstein, Podolsky et Rosen (1935 ; abrégé EPR) exposant ce que l'on appelle maintenant le paradoxe EPR . En supposant ce que l'on appelle maintenant habituellement le réalisme local , l'EPR a tenté de montrer à partir de la théorie quantique qu'une particule a à la fois une position et une quantité de mouvement simultanément, alors que selon l' interprétation de Copenhague , une seule de ces deux propriétés existe réellement et seulement au moment où elle est en train d'être mesuré. EPR a conclu que la théorie quantique est incomplète en ce qu'elle refuse de considérer les propriétés physiques qui existent objectivement dans la nature. (Einstein, Podolsky, & Rosen 1935 est actuellement la publication la plus citée d'Einstein dans les revues de physique.) La même année, Erwin Schrödinger a utilisé le mot « intrication » et a déclaré : « Je n'appellerais pas cela celui-là mais plutôt le trait caractéristique de la mécanique quantique. ." Depuis que le physicien irlandais John Stewart Bell a réfuté théoriquement et expérimentalement la théorie des « variables cachées » d'Einstein, Podolsky et Rosen, la plupart des physiciens ont accepté l'intrication comme un phénomène réel. Cependant, il y a un différend minoritaire. Les inégalités de Bell sont le défi le plus puissant aux affirmations d'Einstein.

Théorie quantique des champs

L'idée de la théorie quantique des champs a commencé à la fin des années 1920 avec le physicien britannique Paul Dirac , lorsqu'il a tenté de quantifier l'énergie du champ électromagnétique ; tout comme en mécanique quantique, l'énergie d'un électron dans l'atome d'hydrogène a été quantifiée. La quantification est une procédure pour construire une théorie quantique à partir d'une théorie classique.

Merriam-Webster définit un domaine en physique comme "une région ou un espace dans lequel un effet donné (comme le magnétisme ) existe". D'autres effets qui se manifestent sous forme de champs sont la gravitation et l'électricité statique . En 2008, le physicien Richard Hammond a écrit :

Parfois, nous distinguons la mécanique quantique (QM) et la théorie quantique des champs (QFT). QM fait référence à un système dans lequel le nombre de particules est fixe et les champs (tels que le champ électromécanique) sont des entités classiques continues. QFT... va encore plus loin et permet la création et l'annihilation de particules...

Il a toutefois ajouté que la mécanique quantique est souvent utilisée pour désigner « toute la notion de vue quantique ».

En 1931, Dirac a proposé l'existence de particules qui deviendront plus tard connues sous le nom d' antimatière . Dirac a partagé le prix Nobel de physique pour 1933 avec Schrödinger « pour la découverte de nouvelles formes productives de la théorie atomique ».

À première vue, la théorie quantique des champs autorise un nombre infini de particules et laisse à la théorie elle-même le soin de prédire combien et avec quelles probabilités ou nombres elles devraient exister. Lorsqu'elle est développée davantage, la théorie contredit souvent l'observation, de sorte que ses opérateurs de création et d'annihilation peuvent être empiriquement liés. De plus, des lois de conservation empiriques telles que celle de la masse-énergie suggèrent certaines contraintes sur la forme mathématique de la théorie, qui sont mathématiquement capricieuses. Ce dernier fait rend les théories quantiques des champs difficiles à manipuler, mais a également conduit à d'autres restrictions sur les formes admissibles de la théorie ; les complications sont mentionnées ci-dessous sous la rubrique de renormalisation .

Électrodynamique quantique

L'électrodynamique quantique (QED) est le nom de la théorie quantique de la force électromagnétique . Comprendre QED commence par comprendre l' électromagnétisme . L'électromagnétisme peut être appelé "électrodynamique" car il s'agit d'une interaction dynamique entre les forces électriques et magnétiques . L'électromagnétisme commence avec la charge électrique .

Les charges électriques sont à l'origine et créent des champs électriques . Un champ électrique est un champ qui exerce une force sur toutes les particules transportant des charges électriques, en tout point de l'espace. Cela inclut l'électron, le proton et même les quarks , entre autres. Lorsqu'une force est exercée, des charges électriques se déplacent, un courant circule et un champ magnétique est produit. Le champ magnétique changeant, à son tour, provoque un courant électrique (souvent des électrons en mouvement). La description physique des particules chargées en interaction , des courants électriques, des champs électriques et des champs magnétiques est appelée électromagnétisme .

En 1928, Paul Dirac a produit une théorie quantique relativiste de l'électromagnétisme. C'était l'ancêtre de l'électrodynamique quantique moderne, en ce sens qu'elle contenait des ingrédients essentiels de la théorie moderne. Cependant, le problème des infinis insolubles s'est développé dans cette théorie quantique relativiste . Des années plus tard, la renormalisation a largement résolu ce problème. Initialement considérée comme une procédure provisoire et suspecte par certains de ses initiateurs, la renormalisation a finalement été adoptée comme un outil important et cohérent en QED et dans d'autres domaines de la physique. De plus, à la fin des années 1940, les diagrammes de Feynman représentaient toutes les interactions possibles sur un événement donné. Les diagrammes ont montré en particulier que la force électromagnétique est l'échange de photons entre particules en interaction.

Le décalage de Lamb est un exemple de prédiction d'électrodynamique quantique qui a été vérifiée expérimentalement. C'est un effet par lequel la nature quantique du champ électromagnétique fait que les niveaux d'énergie dans un atome ou un ion s'écartent légèrement de ce qu'ils seraient autrement. En conséquence, les raies spectrales peuvent se déplacer ou se diviser.

De même, dans une onde électromagnétique se propageant librement, le courant peut également être simplement un courant de déplacement abstrait , au lieu d'impliquer des porteurs de charge. Dans QED, sa description complète fait un usage essentiel de particules virtuelles à courte durée de vie . Là, QED valide à nouveau un concept antérieur, plutôt mystérieux.

Modèle standard

Dans les années 1960, les physiciens se sont rendu compte que le QED s'effondrait à des énergies extrêmement élevées. À partir de cette incohérence, le modèle standard de la physique des particules a été découvert, qui a remédié à la rupture d'énergie plus élevée en théorie. C'est une autre théorie des champs quantiques étendue qui unifie les interactions électromagnétiques et faibles en une seule théorie. C'est ce qu'on appelle la théorie électrofaible .

De plus, le modèle standard contient une unification à haute énergie de la théorie électrofaible avec la force forte , décrite par la chromodynamique quantique . Il postule également une connexion avec la gravité comme une autre théorie de jauge , mais la connexion est encore mal comprise en 2015. La prédiction réussie de la théorie de la particule de Higgs pour expliquer la masse inertielle a été confirmée par le Grand collisionneur de hadrons , et ainsi le modèle standard est maintenant considéré comme la description de base et plus ou moins complète de la physique des particules telle que nous la connaissons.

Interprétations

Les mesures physiques, les équations et les prédictions pertinentes pour la mécanique quantique sont toutes cohérentes et détiennent un très haut niveau de confirmation. Cependant, la question de savoir ce que disent ces modèles abstraits sur la nature sous-jacente du monde réel a reçu des réponses concurrentes. Ces interprétations sont très variées et parfois quelque peu abstraites. Par exemple, l' interprétation de Copenhague déclare qu'avant une mesure, les déclarations sur les propriétés d'une particule n'ont aucun sens, tandis que dans l' interprétation des mondes multiples décrit l'existence d'un multivers composé de tous les univers possibles.

Applications

Les applications de la mécanique quantique comprennent le laser , le transistor , le microscope électronique et l'imagerie par résonance magnétique . Une classe spéciale d'applications de la mécanique quantique est liée aux phénomènes quantiques macroscopiques tels que l'hélium superfluide et les supraconducteurs. L'étude des semi-conducteurs a conduit à l'invention de la diode et du transistor , indispensables à l' électronique moderne .

Même dans le simple interrupteur de lumière , l'effet tunnel quantique est absolument vital, car sinon les électrons du courant électrique ne pourraient pas pénétrer la barrière de potentiel constituée d'une couche d'oxyde. Les puces de mémoire flash trouvées dans les clés USB utilisent également le tunneling quantique pour effacer leurs cellules de mémoire.

Voir également

- Les expériences de pensée d'Einstein

- Phénomènes quantiques macroscopiques

- Philosophie de la physique

- L'informatique quantique

- Particule virtuelle

- Liste des manuels de mécanique classique et quantique

Remarques

Les références

Bibliographie

- Bernstein, Jérémy (2005). "Max Born et la théorie quantique". Journal américain de physique . 73 (11) : 999-1008. Bibcode : 2005AmJPh..73..999B . doi : 10.1119/1.2060717 .

- Beller, Mara (2001). Dialogue quantique : la fabrication d'une révolution . Presse de l'Université de Chicago.

- Bohr, Niels (1958). Physique atomique et connaissances humaines . John Wiley & Fils]. ISBN 0486479285. OCLC 530611 .

- de Broglie, Louis (1953). La Révolution en Physique . Presse du midi. LCCN 53010401 .

- Bronner, Patrick ; Strunz, Andréas; Silberhorn, Christine; Meyn, Jan-Peter (2009). « Démonstration quantique aléatoire avec des photons uniques ». Journal Européen de Physique . 30 (5) : 1189–1200. Bibcode : 2009EJPh ... 30.1189B . doi : 10.1088/0143-0807/30/5/026 .

- Einstein, Albert (1934). Essais en sciences . Bibliothèque philosophique . ISBN 0486470113. LCCN 55003947 .

- Feigl, Herbert ; Brodbeck, mai (1953). Lectures en philosophie des sciences . Appleton-Century-Crofts. ISBN 0390304883. LCCN 53006438 .

- Feynman, Richard P. (1949). "Approche espace-temps de l'électrodynamique quantique" . Examen physique . 76 (6) : 769–89. Bibcode : 1949PhRv ... 76..769F . doi : 10.1103/PhysRev.76.769 .

- Feynman, Richard P. (1990). CQFD, L'étrange théorie de la lumière et de la matière . Livres Pingouin. ISBN 978-0140125054.

- Fowler, Michael (1999). L'atome de Bohr . Université de Virginie.

- Heisenberg, Werner (1958). Physique et Philosophie . Harper et ses frères. ISBN 0061305499. LCCN 99010404 .

- Lakshmibala, S. (2004). « Heisenberg, la mécanique matricielle et le principe d'incertitude ». Résonance: Journal of Science Education . 9 (8) : 46-56. doi : 10.1007/bf02837577 . S2CID 29893512 .

- Liboff, Richard L. (1992). Introduction à la mécanique quantique (2e éd.). Pub Addison-Wesley. Cie ISBN 9780201547153.

- Lindsay, Robert Bruce; Margenau, Henri (1957). Fondements de la physique . Douvres. ISBN 0918024188. LCCN 57014416 .

- McEvoy, juge de paix ; Zarate, Oscar (2004). Présentation de la théorie quantique . ISBN 1874166374.

- Nef, Carl Rod (2005). "Physique quantique" . Hyperphysique . Université d'État de Géorgie.

- Tourbe, F. David (2002). De la certitude à l'incertitude : l'histoire de la science et des idées au XXIe siècle . Presse Joseph Henry .

- Reichenbach, Hans (1944). Fondements philosophiques de la mécanique quantique . Presse de l'Université de Californie. ISBN 0486404595. LCCN a44004471 .

- Schlipp, Paul Arthur (1949). Albert Einstein : philosophe-scientifique . Maison d'édition Tudor. LCCN 50005340 .

- Lecteur scientifique américain , 1953.

- Sears, Francis Weston (1949). Optique (3e éd.). Addison-Wesley. ISBN 0195046013. LCCN 51001018 .

- Shimony, A. (1983). "(titre non donné dans la citation)". Fondements de la mécanique quantique à la lumière des nouvelles technologies (S. Kamefuchi et al., eds.) . Tokyo : Société de physique du Japon. p. 225.; cité dans : Popescu, Sandu ; Daniel Rohrlich (1996). « Action et passion à distance : un essai en l'honneur du professeur Abner Shimony ». arXiv : quant-ph/9605004 .

- Tavel, Morton ; Tavel, Judith (illustrations) (2002). Physique contemporaine et limites du savoir . Presses universitaires Rutgers. ISBN 978-0813530772.

- Van Vleck, JH,1928, "Le principe de correspondance dans l'interprétation statistique de la mécanique quantique", Proc. Natl. Acad. Sci. 14 : 179.

- Westmoreland; Benjamin Schumacher (1998). "L'intrication quantique et l'inexistence de signaux supraluminiques". arXiv : quant-ph/9801014 .

- Wheeler, John Archibald ; Feynman, Richard P. (1949). "Électrodynamique classique en termes d'action directe entre les particules" (PDF) . Critiques de la physique moderne . 21 (3) : 425-33. Bibcode : 1949RvMP ... 21..425W . doi : 10.1103/RevModPhys.21.425 .

- Wieman, Carl ; Perkins, Catherine (2005). "Transformer l'enseignement de la physique". La physique aujourd'hui . 58 (11): 36. bibcode : 2005PhT .... 58k..36W . doi : 10.1063/1.2155756 .

Lectures complémentaires

Les titres suivants, tous écrits par des physiciens en activité, tentent de communiquer la théorie quantique aux profanes, en utilisant un minimum d'appareils techniques.

- Jim Al-Khalili (2003) Quantum: A Guide for the Perplexed . Weidenfeld & Nicolson. ISBN 978-1780225340

- Chester, Marvin (1987) Abécédaire de la mécanique quantique . John Wiley. ISBN 0486428788

- Brian Cox et Jeff Forshaw (2011) L'univers quantique . Allen Lane. ISBN 978-1846144325

- Richard Feynman (1985) CQFD : L'étrange théorie de la lumière et de la matière . Presse de l'Université de Princeton. ISBN 0691083886

- Ford, Kenneth (2005) Le monde quantique . Université Harvard. Presse. Comprend la physique des particules élémentaires.

- Ghirardi, GianCarlo (2004) Regardant furtivement les cartes de Dieu , Gerald Malsbary, trad. Université de Princeton. Presse. Le plus technique des ouvrages cités ici. Les passages utilisant l' algèbre , la trigonométrie et la notation bra-ket peuvent être ignorés lors d'une première lecture.

- Tony Hey et Walters, Patrick (2003) Le nouvel univers quantique . Université de Cambridge Presse. Comprend beaucoup de choses sur les technologies que la théorie quantique a rendues possibles. ISBN 978-0521564571

- Vladimir G. Ivancevic, Tijana T. Ivancevic (2008) Saut quantique : de Dirac et Feynman, À travers l'univers, au corps et à l'esprit humains . Société mondiale d'édition scientifique. Fournit une introduction intuitive en termes non mathématiques et une introduction en termes mathématiques relativement basiques. ISBN 978-9812819277

- N. David Mermin (1990) "Actions effrayantes à distance : mystères du QT" dans ses Boojums tout au long de . Université de Cambridge Appuyez sur : 110-76. L'auteur est un physicien rare qui essaie de communiquer avec les philosophes et les humanistes. ISBN 978-0521388801

- Roland Omnès (1999) Comprendre la mécanique quantique . Université de Princeton. Presse. ISBN 978-0691004358

- Victor Stenger (2000) Réalité intemporelle : symétrie, simplicité et univers multiples . Buffalo NY : Livres de Prometheus. Chpts. 5–8. ISBN 978-1573928595

- Martinus Veltman (2003) Faits et mystères en physique des particules élémentaires . Société mondiale d'édition scientifique. ISBN 978-9812381491

- JP McEvoy et Oscar Zarate (2004). Présentation de la théorie quantique. Livres totémiques. ISBN 1840465778

Liens externes

- " Monde microscopique - Introduction à la mécanique quantique ". par Takada, Kenjiro, professeur émérite à l'Université de Kyushu

- The Quantum Exchange (tutoriels et logiciels d'apprentissage open source).

- Les atomes et le tableau périodique

- Interférence à fente simple et double

- Évolution dans le temps d'un paquet d'ondes dans un puits carré Une démonstration animée d'une dispersion d'un paquet d'ondes dans le temps.

- Expériences avec des photons uniques Une introduction à la physique quantique avec des expériences interactives

- Carroll, Sean M. "La mécanique quantique (un embarras)" . Soixante symboles . Brady Haran pour l'Université de Nottingham.