Méthode de Fisher - Fisher's method

En statistique , la méthode de Fisher , également appelée test de probabilité combinée de Fisher , est une technique de fusion de données ou « méta-analyse » (analyse d'analyses). Il a été développé par et nommé pour Ronald Fisher . Dans sa forme de base, il permet de combiner les résultats de plusieurs tests d'indépendance portant sur une même hypothèse globale ( H 0 ).

Application aux statistiques de tests indépendants

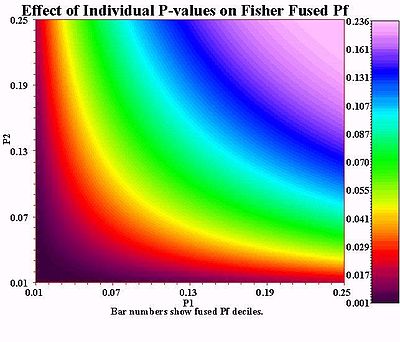

La méthode de Fisher combine les probabilités de valeurs extrêmes de chaque test, communément appelées " valeurs p ", en une statistique de test ( X 2 ) en utilisant la formule

où p i est la valeur p pour la i ème test d'hypothèse. Lorsque les valeurs p ont tendance à être petites, la statistique de test X 2 sera grande, ce qui suggère que les hypothèses nulles ne sont pas vraies pour chaque test.

Lorsque toutes les hypothèses nulles sont vraies et que les p i (ou leurs statistiques de test correspondantes) sont indépendants, X 2 a une distribution du chi carré avec 2 k degrés de liberté , où k est le nombre de tests combinés. Ce fait peut être utilisé pour déterminer la valeur p de X 2 .

La distribution de X 2 est une distribution chi-carré pour la raison suivante ; sous l'hypothèse nulle pour le test i , la p-valeur p i suit une distribution uniforme sur l'intervalle [0,1]. Le logarithme népérien négatif d'une valeur uniformément distribuée suit une distribution exponentielle . La mise à l'échelle d'une valeur qui suit une distribution exponentielle par un facteur de deux donne une quantité qui suit une distribution du Khi deux avec deux degrés de liberté. Enfin, la somme de k valeurs indépendantes du khi-deux, chacune avec deux degrés de liberté, suit une distribution du khi-deux avec 2 k degrés de liberté.

Limites de l'hypothèse d'indépendance

La dépendance entre les tests statistiques est généralement positive, ce qui signifie que la valeur p de X 2 est trop petite (anti-conservatrice) si la dépendance n'est pas prise en compte. Ainsi, si la méthode de Fisher pour les tests indépendants est appliquée dans un cadre dépendant et que la valeur p n'est pas assez petite pour rejeter l'hypothèse nulle, alors cette conclusion restera valable même si la dépendance n'est pas correctement prise en compte. Cependant, si la dépendance positive n'est pas prise en compte et que la valeur p de la méta-analyse s'avère faible, les preuves contre l'hypothèse nulle sont généralement surestimées. Le taux moyen de fausses découvertes , , réduit pour k tests indépendants ou corrélés positivement, peut suffire à contrôler l' alpha pour une comparaison utile avec une valeur p trop faible du X 2 de Fisher .

Extension aux statistiques de test dépendantes

Dans les cas où les tests ne sont pas indépendants, la distribution nulle de X 2 est plus compliquée. Une stratégie courante consiste à approcher la distribution nulle avec une mise à l' échelle χ 2 -distribution variable aléatoire. Différentes approches peuvent être utilisées selon que la covariance entre les différentes valeurs p est connue ou non.

La méthode de Brown peut être utilisée pour combiner des valeurs p dépendantes dont les statistiques de test sous-jacentes ont une distribution normale multivariée avec une matrice de covariance connue. La méthode de Kost étend celle de Brown pour permettre de combiner des valeurs de p lorsque la matrice de covariance n'est connue que jusqu'à un facteur multiplicatif scalaire.

Les moyenne harmonique p -value offre une alternative à la méthode de Fisher pour combiner p -values lorsque la structure de dépendance est inconnue , mais les tests ne peuvent pas être considéré comme indépendant.

Interprétation

La méthode de Fisher est généralement appliquée à une collection de statistiques de test indépendantes, généralement à partir d'études distinctes ayant la même hypothèse nulle. L'hypothèse nulle de la méta-analyse est que toutes les hypothèses nulles distinctes sont vraies. L'hypothèse alternative de la méta-analyse est qu'au moins une des hypothèses alternatives distinctes est vraie.

Dans certains contextes, il est logique d'envisager la possibilité d'une « hétérogénéité », dans laquelle l'hypothèse nulle tient dans certaines études mais pas dans d'autres, ou lorsque différentes hypothèses alternatives peuvent se tenir dans différentes études. Une raison courante de cette dernière forme d'hétérogénéité est que les tailles d'effet peuvent différer parmi les populations. Par exemple, considérons une collection d'études médicales examinant le risque d'un régime alimentaire riche en glucose pour le développement du diabète de type II . En raison de facteurs génétiques ou environnementaux, le risque réel associé à un niveau donné de consommation de glucose peut être plus important dans certaines populations humaines que dans d'autres.

Dans d'autres contextes, l'hypothèse alternative est soit universellement fausse, soit universellement vraie - il n'y a aucune possibilité qu'elle soit valable dans certains contextes mais pas dans d'autres. Par exemple, considérons plusieurs expériences conçues pour tester une loi physique particulière. Tout écart entre les résultats d'études ou d'expériences distinctes doit être dû au hasard, éventuellement dû à des différences de puissance .

Dans le cas d'une méta-analyse utilisant des tests bilatéraux, il est possible de rejeter l'hypothèse nulle de la méta-analyse même lorsque les études individuelles montrent des effets importants dans des directions différentes. Dans ce cas, nous rejetons l'hypothèse selon laquelle l'hypothèse nulle est vraie dans toutes les études, mais cela n'implique pas qu'il existe une hypothèse alternative uniforme qui s'applique à toutes les études. Ainsi, la méta-analyse bilatérale est particulièrement sensible à l'hétérogénéité des hypothèses alternatives. Une méta-analyse unilatérale peut détecter une hétérogénéité dans les amplitudes d'effet, mais se concentre sur une seule direction d'effet prédéfinie.

Relation avec la méthode du Z-score de Stouffer

Une approche étroitement liée à la méthode de Fisher est le Z de Stouffer, basé sur les scores Z plutôt que sur les valeurs p, permettant l'incorporation de poids d'étude. Il porte le nom du sociologue Samuel A. Stouffer . Si nous laissons Z i = Φ − 1 (1− p i ), où Φ est la fonction de distribution cumulative normale standard , alors

est un Z-score pour la méta-analyse globale. Ce score Z est approprié pour les valeurs p unilatérales à queue droite ; des modifications mineures peuvent être apportées si des valeurs p bilatérales ou unilatérales sont analysées. Plus précisément, si des valeurs p bilatérales sont analysées, la valeur p bilatérale (p i /2) est utilisée, ou 1-p i si des valeurs p unilatérales sont utilisées.

Étant donné que la méthode de Fisher est basée sur la moyenne des valeurs de −log( p i ) et que la méthode du score Z est basée sur la moyenne des valeurs de Z i , la relation entre ces deux approches découle de la relation entre z et −log( p ) = −log(1− Φ ( z )). Pour la distribution normale, ces deux valeurs ne sont pas parfaitement linéairement liées, mais elles suivent une relation très linéaire sur la plage de valeurs Z le plus souvent observée, de 1 à 5. En conséquence, la puissance de la méthode du Z-score est presque identique à la puissance de la méthode de Fisher.

L'un des avantages de l'approche du score Z est qu'il est simple d'introduire des poids. Si le i e Z-score est pondéré par w i , le Z-score méta-analyse est

qui suit une distribution normale standard sous l'hypothèse nulle. Alors que des versions pondérées de la statistique de Fisher peuvent être dérivées, la distribution nulle devient une somme pondérée de statistiques indépendantes du Khi-deux, ce qui est moins pratique à utiliser.

Les références

- ^ Fisher, RA (1925). Méthodes statistiques pour les chercheurs . Oliver et Boyd (Édimbourg). ISBN 0-05-002170-2.

- ^ Fisher, RA; Fisher, R.A (1948). "Questions et réponses #14". Le statisticien américain . 2 (5) : 30-31. doi : 10.2307/2681650 . JSTOR 2681650 .

- ^ Brown, M. (1975). « Une méthode pour combiner des tests de signification non indépendants et unilatéraux ». Biométrie . 31 (4) : 987–992. doi : 10.2307/2529826 . JSTOR 2529826 .

- ^ Kost, J.; McDermott, M. (2002). "Combinant des valeurs P dépendantes". Statistiques et lettres de probabilité . 60 (2) : 183-190. doi : 10.1016/S0167-7152(02)00310-3 .

- ^ Bon, IJ (1958). « Tests de signification en parallèle et en série ». Journal de l'Association statistique américaine . 53 (284) : 799-813. doi : 10.1080/01621459.1958.10501480 . JSTOR 2281953 .

- ^ Wilson, DJ (2019). "La valeur p moyenne harmonique pour combiner des tests dépendants" . Actes de l'Académie nationale des sciences des États-Unis . 116 (4) : 1195–1200. doi : 10.1073/pnas.1814092116 . PMC 6347718 . PMID 30610179 .

- ^ Stouffer, SA; Suchman, EA; DeVinney, LC ; Étoile, SA ; Williams, RM Jr. (1949). Le soldat américain, Vol.1 : Ajustement pendant la vie de l'armée . Presse universitaire de Princeton, Princeton.

- ^ "Test des valeurs p bilatérales en utilisant l'approche de Stouffer" . stats.stackexchange.com . Récupéré le 2015-09-14 .

- ^ Mosteller, F.; Bush, RR (1954). "Techniques quantitatives sélectionnées". Dans Lindzey, G. (éd.). Manuel de psychologie sociale, Vol1 . Addison_Wesley, Cambridge, Mass. pp. 289-334.

- ^ Liptak, T. (1958). "Sur la combinaison de tests indépendants". Magyar Tud. Akad. Tapis. Kutato Int. Kozl . 3 : 171-197.

Voir également

- Extensions de la méthode de Fisher

- Une source alternative pour la note de Fisher de 1948 : [1]

- Le Z-score de Fisher, Stouffer et quelques méthodes apparentées sont implémentés dans le package metap R.