Cœur graphique suivant - Graphics Core Next

Graphics Core Next ( GCN ) est le nom de code d'une série de microarchitectures ainsi que d'une architecture de jeu d'instructions qui a été développée par AMD pour leurs GPU en tant que successeur de leur microarchitecture/jeu d'instructions TeraScale . Le premier produit intégrant GCN a été lancé le 9 janvier 2012.

GCN est une microarchitecture RISC SIMD (ou plutôt SIMT ) contrastant avec l' architecture VLIW SIMD de TeraScale. GCN nécessite considérablement plus de transistors que TeraScale, mais offre des avantages pour le calcul GPGPU . Cela rend le compilateur plus simple et devrait également conduire à une meilleure utilisation.

Les puces graphiques GCN sont fabriquées avec CMOS à 28 nm , et avec FinFET à 14 nm (par Samsung Electronics et GlobalFoundries ) et 7 nm (par TSMC ), disponibles sur certains modèles dans les Radeon HD 7000 , HD 8000 , 200 , 300 , 400 , 500 et Vega de cartes graphiques AMD Radeon, y compris la Radeon VII publiée séparément. GCN est également utilisé dans la partie graphique des unités de traitement accéléré AMD (APU), comme dans les APU PlayStation 4 et Xbox One .

Jeu d'instructions

Le jeu d'instructions GCN appartient à AMD (qui possède également le jeu d' instructions X86-64 ). Le jeu d'instructions GCN a été développé spécifiquement pour les GPU (et GPGPU) et, par exemple, n'a pas de micro-opération pour la division .

La documentation est disponible pour :

- le jeu d'instructions Graphics Core Next 1

- le jeu d'instructions Graphics Core Next 2

- le jeu d'instructions Graphics Core Next 3

- le Graphics Core Next 4 : La documentation du jeu d'instructions GCN 4 est la même que pour la 3ème génération.

- le jeu d'instructions Graphics Core Next 5 (également appelé Vega )

Un générateur de code LLVM (un back-end de compilateur) est disponible pour le jeu d'instructions GCN. Il est utilisé par Mesa 3D .

La collection de compilateurs GNU (GCC) prend en charge GCN 3 (Fidji, Carrizo) et GCN 5 (Vega) depuis 2019 (GCC 9) pour les programmes autonomes à thread unique et avec GCC 10 également déchargé via OpenMP et OpenACC .

MIAOW est une implémentation RTL open source du jeu d'instructions AMD Southern Islands GPGPU (alias Graphics Core Next).

En novembre 2015, AMD a annoncé l'« Initiative Boltzmann ». L'initiative AMD Boltzmann permettra le portage d' applications basées sur CUDA vers un modèle de programmation C++ commun .

Au "Super Computing 15", AMD a présenté son Heterogeneous Compute Compiler (HCC), un pilote Linux sans tête et une infrastructure d'exécution HSA pour le calcul haute performance (HPC) de classe cluster et l'outil Heterogeneous-Compute Interface for Portability (HIP) pour le portage Applications basées sur CUDA à un modèle de programmation C++ commun.

Microarchitectures

En juillet 2017, la famille de microarchitectures implémentant le jeu d'instructions identiquement appelé "Graphics Core Next" a connu cinq itérations. Les différences dans le jeu d'instructions sont plutôt minimes et ne se différencient pas trop les unes des autres. Une exception est l'architecture GCN de cinquième génération, qui a fortement modifié les processeurs de flux pour améliorer les performances et prendre en charge le traitement simultané de deux nombres de précision inférieure à la place d'un seul nombre de précision supérieure.

Traitement des commandes

Processeur de commande graphique

Le "Graphics Command Processor" (GCP) est une unité fonctionnelle de la microarchitecture GCN. Entre autres tâches, il est responsable des shaders asynchrones. La courte vidéo AMD Asynchronous Shaders visualise les différences entre « multi thread », « préemption » et « Asynchronous Shaders ».

Moteur de calcul asynchrone

Le moteur de calcul asynchrone (ACE) est un bloc fonctionnel distinct servant à des fins de calcul. Son objectif est similaire à celui du processeur de commandes graphiques.

Planificateur

Depuis la troisième itération de GCN, le matériel contient deux planificateurs : un pour planifier les fronts d'onde pendant l'exécution du shader (CU Scheduler, voir ci-dessous) et un nouveau pour planifier l'exécution des files d'attente de dessin et de calcul. Ce dernier améliore les performances en exécutant des opérations de calcul lorsque les CU sont sous-utilisées en raison de commandes graphiques limitées par une vitesse de pipeline de fonction fixe ou une bande passante limitée. Cette fonctionnalité est connue sous le nom de calcul asynchrone.

Pour un shader donné, les pilotes GPU doivent également sélectionner un bon ordre d'instructions, afin de minimiser la latence. Cela se fait sur le processeur, et est parfois appelé "Scheduling".

Processeur géométrique

Le processeur de géométrie contient le Geometry Assembler, le Tesselator et le Vertex Assembler.

Le GCN Tesselator du processeur Geometry est capable d'effectuer la tessellation dans le matériel tel que défini par Direct3D 11 et OpenGL 4.5 (voir AMD le 21 janvier 2017).

Le GCN Tesselator est le bloc SIP le plus récent d'AMD, les unités antérieures étaient ATI TruForm et la tessellation matérielle dans TeraScale .

Unités de calcul

Une unité de calcul combine 64 processeurs shader avec 4 TMU . L'unité de calcul est distincte des unités de sortie de rendu (ROP) mais alimente celles-ci . Chaque unité de calcul se compose d'un planificateur CU, d'une unité de branchement et de message, de 4 unités vectorielles SIMD (chacune de 16 voies de large), de 4 fichiers VGPR de 64 Ko, d'une unité scalaire, d'un fichier GPR de 4 Ko, d'un partage de données local de 64 Ko, 4 unités de filtre de texture, 16 unités de chargement/stockage de récupération de texture et un cache L1 de 16 Ko. Quatre unités de calcul sont câblées pour partager un cache d'instructions L1 de 16 Ko et un cache de données L1 de 32 Ko, tous deux en lecture seule. Un SIMD-VU fonctionne sur 16 éléments à la fois (par cycle), tandis qu'un SU peut fonctionner sur un à la fois (un/cycle). De plus, le SU gère d'autres opérations comme le branchement.

Chaque SIMD-VU a une mémoire privée où il stocke ses registres. Il existe deux types de registres : les registres scalaires (s0, s1, etc.), qui contiennent chacun un numéro de 4 octets, et les registres vectoriels (v0, v1, etc.), qui représentent chacun un ensemble de 64 numéros de 4 octets. Lorsque vous opérez sur les registres vectoriels, chaque opération se fait en parallèle sur les 64 nombres. Chaque fois que vous travaillez avec eux, vous travaillez en fait avec 64 entrées. Par exemple, vous travaillez sur 64 pixels différents à la fois (pour chacun d'eux, les entrées sont légèrement différentes, et vous obtenez donc une couleur légèrement différente à la fin).

Chaque SIMD-VU peut contenir 512 registres scalaires et 256 registres vectoriels.

Planificateur CU

L'ordonnanceur CU est le bloc fonctionnel matériel qui choisit pour le SIMD-VU les fronts d'onde à exécuter. Il sélectionne un SIMD-VU par cycle pour la planification. Il ne faut pas le confondre avec d'autres ordonnanceurs, en matériel ou en logiciel.

- Front d'onde

- Un ' shader ' est un petit programme écrit en GLSL qui effectue un traitement graphique, et un ' kernel ' est un petit programme écrit en OpenCL et effectuant un traitement GPGPU. Ces processus n'ont pas besoin d'autant de registres, ils ont besoin de charger des données à partir de la mémoire système ou graphique. Cette opération s'accompagne d'une latence importante. AMD et Nvidia ont choisi des approches similaires pour masquer cette latence inévitable : le regroupement de plusieurs threads . AMD appelle un tel groupe un front d'onde, Nvidia l'appelle une chaîne. Un groupe de threads est l'unité de planification la plus basique des GPU mettant en œuvre cette approche pour masquer la latence, est la taille minimale des données traitées à la manière SIMD, la plus petite unité de code exécutable, la façon de traiter une seule instruction sur tous les threads dedans en même temps.

Dans tous les GCN-GPU, un "front d'onde" se compose de 64 threads, et dans tous les GPU Nvidia, un "warp" se compose de 32 threads.

La solution d'AMD consiste à attribuer plusieurs fronts d'onde à chaque SIMD-VU. Le matériel distribue les registres aux différents fronts d'onde, et lorsqu'un front d'onde attend un résultat, qui se trouve dans la mémoire, le planificateur CU décide de faire fonctionner le SIMD-VU sur un autre front d'onde. Les fronts d'onde sont attribués par SIMD-VU. Les SIMD-VU n'échangent pas de fronts d'onde. Au maximum 10 fronts d'onde peuvent être attribués par SIMD-VU (donc 40 par CU).

AMD CodeXL affiche des tableaux avec la relation entre le nombre de SGPR et de VGPR et le nombre de fronts d'onde, mais fondamentalement pour SGPRS, il s'agit de min(104, 512/numwavefronts) et VGPRS 256/numwavefronts.

Notez qu'en conjonction avec les instructions SSE, ce concept de niveau de parallélisme le plus basique est souvent appelé "largeur vectorielle". La largeur du vecteur est caractérisée par le nombre total de bits qu'il contient.

Unité vectorielle SIMD

Chaque unité vectorielle SIMD possède :

- un nombre entier à 16 voies et un vecteur à virgule flottante, une unité logique arithmétique (ALU)

- Fichier de registre vectoriel à usage général (VGPR) de 64 Kio

- Un compteur de programme 48 bits

- Tampon d'instructions pour 10 fronts d'onde

- Un front d'onde est un groupe de 64 threads : la taille d'un VGPR logique

- Un front d'onde à 64 threads est transmis à une unité SIMD à 16 voies sur quatre cycles

Chaque SIMD-VU a 10 tampons d'instructions de front d'onde, et il faut 4 cycles pour exécuter un front d'onde.

Blocs d'accélération audio et vidéo

De nombreuses implémentations de GCN sont généralement accompagnées de plusieurs autres blocs ASIC d'AMD . Y compris, mais sans s'y limiter, le décodeur vidéo unifié , le moteur de codage vidéo et AMD TrueAudio .

Moteur de codage vidéo

TrueAudio

Mémoire virtuelle unifiée

Dans un aperçu en 2011, AnandTech a écrit sur la mémoire virtuelle unifiée, prise en charge par Graphics Core Next.

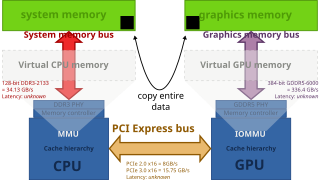

Architecture d'ordinateur de bureau classique avec une carte graphique distincte sur PCI Express . Le CPU et le GPU ont leur mémoire physique distincte, avec des espaces d'adressage différents. L'intégralité des données doit être copiée sur le bus PCIe. Remarque : le diagramme montre les bandes passantes, mais pas la latence mémoire .

GCN prend en charge la "mémoire virtuelle unifiée", activant ainsi la copie zéro , au lieu des données, seuls les pointeurs sont copiés, "passés". Il s'agit d'une fonctionnalité HSA primordiale .

Les solutions graphiques intégrées (et les APU AMD avec graphiques TeraScale ) souffrent d'une mémoire principale partitionnée : une partie de la mémoire système est allouée exclusivement au GPU. La copie zéro n'est pas possible, les données doivent être copiées (sur le bus mémoire système) d'une partition à l'autre.

Les APU AMD avec gain graphique GCN à partir de la mémoire principale unifiée préservent la bande passante limitée.

Architecture de système hétérogène (HSA)

Certaines des fonctionnalités HSA spécifiques implémentées dans le matériel nécessitent la prise en charge du noyau du système d' exploitation (ses sous-systèmes) et/ou de pilotes de périphériques spécifiques. Par exemple, en juillet 2014, AMD a publié un ensemble de 83 correctifs à fusionner dans la ligne principale du noyau Linux 3.17 pour prendre en charge leurs cartes graphiques Radeon basées sur Graphics Core Next . Le pilote spécial intitulé « pilote du noyau HSA » réside dans le répertoire /drivers/gpu/hsa tandis que les pilotes de périphériques graphiques DRM résident dans /drivers/gpu/drm et augmentent le pilote DRM déjà existant pour les cartes Radeon. Cette toute première implémentation se concentre sur un seul APU "Kaveri" et fonctionne avec le pilote graphique du noyau Radeon existant (kgd).

Compression Delta Color sans perte

Planificateurs de matériel

Ils sont utilisés pour effectuer la planification et décharger l'affectation des files d'attente de calcul aux ACE du pilote au matériel en mettant ces files d'attente en mémoire tampon jusqu'à ce qu'il y ait au moins une file d'attente vide dans au moins un ACE, obligeant le HWS à attribuer immédiatement des files d'attente en mémoire tampon aux ACE. jusqu'à ce que toutes les files d'attente soient pleines ou qu'il n'y ait plus de files d'attente à affecter en toute sécurité. Une partie du travail de planification effectué comprend des files d'attente hiérarchisées qui permettent aux tâches critiques de s'exécuter à une priorité plus élevée que d'autres tâches sans exiger que les tâches de priorité inférieure soient préemptées pour exécuter la tâche à priorité élevée, permettant ainsi aux tâches de s'exécuter simultanément avec les tâches à haute priorité programmé pour monopoliser le GPU autant que possible tout en laissant les autres tâches utiliser les ressources que les tâches prioritaires n'utilisent pas. Ce sont essentiellement des moteurs de calcul asynchrones qui manquent de contrôleurs de répartition. Ils ont été introduits pour la première fois dans la microarchitecture GCN de quatrième génération, mais étaient présents dans la microarchitecture GCN de troisième génération à des fins de test interne. Une mise à jour du pilote a activé les planificateurs matériels dans les pièces GCN de troisième génération pour une utilisation en production.

Accélérateur de rejet primitif

Cette unité rejette les triangles dégénérés avant qu'ils n'entrent dans le shader de sommet et les triangles qui ne couvrent aucun fragment avant qu'ils n'entrent dans le shader de fragment. Cette unité a été introduite avec la microarchitecture GCN de quatrième génération.

Générations

Cœur graphique Suivant 1

| Date de sortie | janvier 2012 |

|---|---|

| Histoire | |

| Prédécesseur | Échelle Tera 3 |

| Successeur | Cœur graphique suivant 2 |

La microarchitecture GCN 1 a été utilisée dans plusieurs cartes graphiques de la série Radeon HD 7000 .

- prise en charge de l'adressage 64 bits ( espace d' adressage x86-64 ) avec espace d'adressage unifié pour CPU et GPU

- prise en charge de PCI-E 3.0

- Le GPU envoie des demandes d'interruption au CPU sur divers événements (tels que les défauts de page )

- prise en charge des textures partiellement résidentes, qui permettent la prise en charge de la mémoire virtuelle via les extensions DirectX et OpenGL

- Prise en charge AMD PowerTune , qui ajuste dynamiquement les performances pour rester dans un TDP spécifique

- prise en charge de Mantle (API)

Il existe des moteurs de calcul asynchrones contrôlant le calcul et la répartition.

Puissance ZeroCore

ZeroCore Power est une technologie d'économie d'énergie pendant une longue période d'inactivité, qui éteint les unités fonctionnelles du GPU lorsqu'elles ne sont pas utilisées. La technologie AMD ZeroCore Power complète AMD PowerTune .

Chips

GPU discrets (famille des îles du Sud) :

- Oland

- Cap-Vert

- Pitcairn

- Tahiti

Cœur graphique suivant 2

| Date de sortie | septembre 2013 |

|---|---|

| Histoire | |

| Prédécesseur | Cœur graphique Suivant 1 |

| Successeur | Cœur graphique suivant 3 |

GCN 2ème génération a été introduit avec Radeon HD 7790 et se trouve également dans Radeon HD 8770 , R7 260/260X, R9 290/290X, R9 295X2 , R7 360, R9 390/390X , ainsi que dans les APU Kaveri et Mobile basés sur Steamroller . APU Kaveri et dans les APU "Beema" et "Mullins" basés sur Puma . Il présente de multiples avantages par rapport au GCN d'origine, notamment la prise en charge de FreeSync , AMD TrueAudio et une version révisée de la technologie AMD PowerTune .

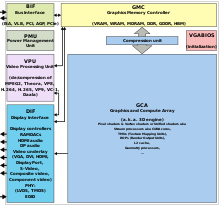

GCN 2e génération a introduit une entité appelée "Shader Engine" (SE). Un Shader Engine comprend un processeur de géométrie, jusqu'à 44 CU (puce Hawaii), des rastériseurs, des ROP et un cache L1. Le processeur de commande graphique, les 8 ACE, les contrôleurs de cache et de mémoire L2 ainsi que les accélérateurs audio et vidéo, les contrôleurs d'affichage, les 2 contrôleurs DMA et l' interface PCIe ne font pas partie d'un moteur de shader .

L' A10-7850K "Kaveri" contient 8 CU (unités de calcul) et 8 moteurs de calcul asynchrones pour une planification indépendante et une répartition des éléments de travail.

Lors de l'AMD Developer Summit (APU) en novembre 2013, Michael Mantor a présenté la Radeon R9 290X .

Chips

GPU discrets (famille Sea Islands) :

- Bonaire

- Hawaii

intégré aux APU :

- Temash

- Kabini

- Liverpool (c'est-à-dire l'APU trouvé dans la PlayStation 4)

- Durango (c'est-à-dire l'APU trouvé dans la Xbox One et la Xbox One S)

- Kaveri

- Godavari

- Mullins

- Beéma

- Carrizo-L

Cœur graphique suivant 3

| Date de sortie | juin 2015 |

|---|---|

| Histoire | |

| Prédécesseur | Cœur graphique suivant 2 |

| Successeur | Cœur graphique suivant 4 |

GCN 3ème génération a été introduit en 2014 avec les Radeon R9 285 et R9 M295X, qui ont le GPU "Tonga". Il présente des performances de tessellation améliorées, une compression de couleur delta sans perte pour réduire l'utilisation de la bande passante mémoire, un jeu d'instructions mis à jour et plus efficace, un nouveau scaler de haute qualité pour la vidéo et un nouveau moteur multimédia (encodeur/décodeur vidéo). La compression des couleurs delta est prise en charge dans Mesa. Cependant, ses performances en double précision sont moins bonnes que celles de la génération précédente.

Chips

GPU discrets :

- Tonga (famille Volcanic Islands), est livré avec UVD 5.0 (Unified Video Decoder)

- Fidji (famille Pirate Islands), est livré avec UVD 6.0 et mémoire à bande passante élevée (HBM 1)

intégré aux APU :

- Carrizo, livré avec UVD 6.0

- La crête de Bristol

- Stoney Ridge

Cœur graphique suivant 4

| Date de sortie | juin 2016 |

|---|---|

| Histoire | |

| Prédécesseur | Cœur graphique suivant 3 |

| Successeur | Cœur graphique Suivant 5 |

Les GPU de la famille Arctic Islands ont été introduits au deuxième trimestre de 2016 avec la série AMD Radeon 400 . Le moteur 3D (c'est-à-dire GCA (Graphics and Compute array) ou GFX) est identique à celui des puces Tonga. Mais Polaris dispose d'un moteur de contrôleur d'affichage plus récent, UVD version 6.3, etc.

Toutes les puces basées sur Polaris autres que le Polaris 30 sont produites sur le processus FinFET 14 nm , développé par Samsung Electronics et sous licence GlobalFoundries . Le Polaris 30 rafraîchi légèrement plus récent est construit sur le nœud de processus LP FinFET 12 nm , développé par Samsung et GlobalFoundries. L'architecture du jeu d'instructions GCN de quatrième génération est compatible avec la troisième génération. Il s'agit d'une optimisation pour le processus FinFET 14 nm permettant des vitesses d'horloge GPU plus élevées qu'avec la 3e génération GCN. Les améliorations architecturales incluent de nouveaux planificateurs matériels, un nouvel accélérateur de suppression primitive, un nouveau contrôleur d'affichage et un UVD mis à jour qui peut décoder HEVC à des résolutions 4K à 60 images par seconde avec 10 bits par canal de couleur.

Chips

GPU discrets :

- Polaris 10 (également sous le nom de code Ellesmere ) trouvé sur les cartes graphiques de marque « Radeon RX 470 » et « Radeon RX 480 »

- Polaris 11 (également sous le nom de code Baffin ) trouvé sur les cartes graphiques de marque « Radeon RX 460 » (également Radeon RX 560 D )

- Polaris 12 (également nommé Lexa) trouvé sur les cartes graphiques de marque « Radeon RX 550 » et « Radeon RX 540 »

- Polaris 20, qui est un Polaris 10 rafraîchi ( 14 nm LPP Samsung / GloFo FinFET ) avec des horloges plus élevées, utilisé pour les cartes graphiques de marque "Radeon RX 570" et "Radeon RX 580"

- Polaris 21, qui est un nouveau procédé 14 nm LPP Samsung/GloFo FinFET) Polaris 11, utilisé pour les cartes graphiques de marque "Radeon RX 560"

- Polaris 22, trouvé sur les cartes graphiques de marque « Radeon RX Vega M GH » et « Radeon RX Vega M GL » (dans le cadre de Kaby Lake-G )

- Polaris 30, qui est un Polaris 20 actualisé ( processus LP GloFo FinFET 12 nm ) avec des horloges plus élevées, utilisé pour les cartes graphiques de marque "Radeon RX 590"

En plus des GPU dédiés, Polaris est utilisé dans les APU de la PlayStation 4 Pro et de la Xbox One X, intitulés respectivement "Neo" et "Scorpio".

Performances de précision

La performance FP64 de tous les processeurs de 4ème génération GCN est 1 / 16 de la performance FP32.

Cœur graphique Suivant 5

| Date de sortie | juin 2017 |

|---|---|

| Histoire | |

| Prédécesseur | Cœur graphique suivant 4 |

| Successeur | ADN 1 |

AMD a commencé à publier les détails de sa prochaine génération d'architecture GCN, appelée « unité de calcul de nouvelle génération », en janvier 2017. La nouvelle conception devait augmenter le nombre d' instructions par horloge , des vitesses d'horloge plus élevées , la prise en charge de HBM2 , un espace d'adressage mémoire plus important . . Les chipsets graphiques discrets incluent également "HBCC (High Bandwidth Cache Controller)", mais pas lorsqu'ils sont intégrés dans des APU. De plus, les nouvelles puces devaient inclure des améliorations dans les unités de sortie de rastérisation et de rendu . Les processeurs de flux sont fortement modifiés par rapport aux générations précédentes pour prendre en charge la technologie mathématique compacte Rapid Pack Math pour les nombres 8 bits, 16 bits et 32 bits. Avec cela, il y a un avantage significatif en termes de performances lorsqu'une précision inférieure est acceptable (par exemple : traitement de deux nombres en demi-précision au même rythme qu'un seul nombre en simple précision ).

Nvidia a introduit la rastérisation et le binning basés sur des tuiles avec Maxwell , et c'était une grande raison pour l'augmentation de l'efficacité de Maxwell. En janvier, AnandTech a supposé que Vega rattraperait enfin Nvidia en ce qui concerne les optimisations d'efficacité énergétique grâce au nouveau "DSBR (Draw Stream Binning Rasterizer)" qui sera introduit avec Vega.

Il a également ajouté la prise en charge d'une nouvelle étape de shader - Primitive Shaders. Les shaders primitifs offrent un traitement de géométrie plus flexible et remplacent les shaders de vertex et de géométrie dans un pipeline de rendu. Depuis décembre 2018, les shaders Primitive ne peuvent pas être utilisés car les modifications d'API requises n'ont pas encore été apportées.

Vega 10 et Vega 12 utilisent le processus FinFET 14 nm , développé par Samsung Electronics et licencié à GlobalFoundries . Vega 20 utilise le procédé FinFET 7 nm développé par TSMC .

Chips

GPU discrets :

- Vega 10 ( processus Samsung / GloFo FinFET 14 nm ) (également nommé Groenland ) trouvé sur "Radeon RX Vega 64", "Radeon RX Vega 56", "Radeon Vega Frontier Edition", "Radeon Pro V340", Radeon Pro WX 9100, et cartes graphiques Radeon Pro WX 8200

- Vega 12 (processus Samsung/GloFo FinFET 14 nm) trouvé sur les cartes graphiques mobiles de marque « Radeon Pro Vega 20 » et « Radeon Pro Vega 16 »

- Vega 20 ( processus FinFET TSMC 7 nm ) présent sur les cartes accélératrices de marque « Radeon Instinct MI50 » et « Radeon Instinct MI60 », « Radeon Pro Vega II » et « Radeon VII ».

intégré aux APU :

- Raven Ridge est venu avec VCN 1 qui remplace VCE et UVD et permet un décodage VP9 à fonction fixe complète.

Performances de précision

Double précision à virgule flottante (FP64) les performances de tous les GPU 5ème génération de GCN, à l' exception de Vega 20, est 1 / seize des performances FP32. Pour Vega 20 c'est 1 / 2 de la performance FP32. Tous les GPU GCN de 5e génération prennent en charge les calculs à virgule flottante demi-précision (FP16), soit le double des performances du FP32.